Gökada Büyüklüğünde Bir Canlı Olabilir mi?

Evrendeki nesnelerin boyutları, 10-19 metre ölçeğindeki kuark etkileşimlerinden 1026 metreuzaklıktaki kozmik ufka kadar değişir. Bu 45 olası büyüklük mertebesinde, bildiğimiz kadarıyla yaşam oldukça ufak bir aralıkla sınırlanmış durumda: 45 olası mertebenin kabaca orta bölümüne denk gelen yaklaşık 9 farklı büyüklük mertebesinde canlı bulunabiliyor. İnsan benzeri duygu ve düşüncelere sahip canlıların bulunduğu aralık ise 9 mertebenin sadece 3’ünü kapsıyor.

Bakteriler ve virüsler bir mikrondan, yani 10-6 metreden bile küçük olabilirken, en büyük ağaçların uzunluğu 100 metreye varabiliyor. Oregon’da bulunan Mavi Dağlar’ın altında yaşayan bal mantarını tek bir organizma olarak düşünürsek, yaklaşık 4 km boyunca uzandığını da anımsayalım. Peki acaba canlıların büyüklüğünü sınırlayan evrensel bir limit var mı?

Hesaplama kuramındaki gelişmeler sonucunda, bilinç ve zeka için katrilyonlarca ilkel “devre” elemanı gerektiğini öğrendik. Beyinlerimiz nöronlardan oluştuğuna göre, ki nöronların her biri özelleşmiş ve işbirliği yapan tek hücreli organizmalardır; biyolojik bilgisayarların bizim becerilerimizi sergileyebilmesi için bizim beynimizin fiziksel büyüklüğüne yakın boyutta olmaları gerekir.

Yapay zeka sistemlerinde bizimkinden daha küçük nöronlar yapılandırmayı düşünebiliriz. Elektronik devre elemanları, örneğin, şu anda nöronlardan oldukça küçüktür. Fakat davranışları da daha basittir ve epey hacim kaplayan destek (enerji, soğutma, iletişim) yapılarına gereksinim duyarlar. Büyük olasılıkla ilk yapay zekaların kaplayacağı hacim, yapıldıkları malzemeler ve mimarileri bizden bütünüyle farklı olduğu halde, bizim bedenlerimizin boyutlarında olacaktır. Bu durum, metre ölçeğinin bir özelliği olduğuna bir kez daha işaret ediyor.

Peki ya evrenin büyükler ucu ne alemde? William S. Burroughs’un Patlamış Bilet adlı kitabında, yüzeyinin altında, yavaşça oluşan kristallerinde neredeyse sıfır düşünce olan engin bir mineral bilinç yatan bir gezegen kurgulanmıştır. Gökbilimci Fred Hoyle “Siyah Bulut” adını verdiği, boyutu Dünya ile Güneş arası uzaklıkla kıyaslanabilecek kadar olan bilinçli bir hiper-zekadan dramatik ve ikna edici biçimde söz etmiştir. Bu düşüncesi, bir yıldızı bütünüyle çevreleyen ve enerjisinin büyük bölümünü yakalayan devasa yapılar olan Dyson küreleri kavramını önceden sezmiş gibidir.

Peki bu büyüklükte yaşam formlarının varolması için koşullar nelerdir? İlginç düşünceler için karmaşık bir beynin yanı sıra yeterince zamana da gerek vardır. Nöral aktarımların hızı yaklaşık olarak saatte 300 km civarındadır. Dolayısıyla insan beyninde sinyal iletim hızı 1 milisaniye kadardır. O halde bir insan ömrü, 2 trilyon mesaj iletim süresinden oluşuyor demektir. Eğer beyinlerimiz ve nöronlarımız 10 kat daha büyük olsaydı, yaşam sürelerimiz ve nöral sinyal hızlarımız da aynı kalsaydı, yaşamımız boyunca şimdikinin onda biri kadar düşüncemiz olurdu.

Beyinlerimizin aşırı ölçüde, örneğin güneş sistemi kadar büyüdüğünü düşünelim. O zaman aynı sayıda mesaj iletimi için evrenin toplam yaşından fazla zaman gerekirdi. Evrimin akışı için de hiç zaman kalmazdı. Eğer gökadamız büyüklüğünde bir beyin olsaydı, sorun daha da içinden çıkılmaz hal alırdı. Oluşum anından itibaren sadece 10.000 civarında mesaj bir uçtan diğerine gidebilirdi. Yani karmaşıklığı insan beynininkine yakın ama büyüklüğü astronomik ölçekte bir beyni olan yaşayan bir varlık hayal edebilmek pek mümkün değil. Eğer varolsaydı da, herhangi bir şey yapabilecek zamanı olmazdı.

Dikkat çekici bir diğer nokta, fiziksel bedenler üzerinde çevrenin koyduğu sınırlamaların da yaşamın hemen hemen zekanın gerektirdiği boyutları gerektiriyor olması. En uzun sekoya ağaçlarının boyu, suyu yukarı doğru 100 metreden fazla pompalayamıyor oluşları ile sınırlanmıştır. Bu limit, Dünya’nın yerçekim kuvveti (suyu aşağı çeker), terleme, su tutunumu ve bitkinin ksilemindeki (suyu yukarı iter) yüzey geriliminin ortak etkisi ile belirir1. Eğer yaşama en uygun gezegenlerin çekim kuvveti ve atmosfer basıncının Dünya’nınkinin 10 katına kadar olduğunu varsayarsak, aynı maksimum limitinin birkaç katı büyüklük mertebesinde kalmış oluruz.

Gezegendeki en büyük ağaçlardan sekoya ağaçları görülüyor.

Ayrıca canlıların çoğunun bir gezegene, uyduya veya göktaşına bağlı yaşayacağını farz edersek, yerçekimi de doğal bir ölçek belirler. Gezegen büyüdükçe ve yerçekimi arttıkça, kemiklere (ya da onların eşdeğerine) binen kuvvet de artar. Bu konu 1600’lerde Christiaan Huygens tarafından tartışılmıştır. Söz konusu durumda canlının kemiklerinin kesitinin de, kuvvete dayanmak için hayvanın büyüklüğünün karesiyle orantılı olarak genişlemesi gerekecektir. Ancak bu vücut geliştirme çabaları, nihayetinde kendi kendini sınırlar; çünkü kütle de uzunluğun kübüyle orantılı artar. Genel olarak, hareket edebilen dünya organizmalarının maksimum kütlesi, kütleçekimin gücünün arttığı oranda azalır. Örneğin yerçekimi Dünya’dakinin 10’da 1’i kadar olan bir gezegende, hayvanların 10 kat daha büyük olma olasılığı vardır.

Tabi bir gezegenin de ne kadar küçük olabileceğine ilişkin bir limit vardır. Çok küçük gezegenler (mesela Dünya’nın kütlesinin onda birinden daha küçük olanlar) atmosferi çekecek ve tutacak kadar kütleçekime sahip olmazlar. Yani bir kez daha Dünya’da gördüğümüz boyutlara yakın büyüklükleri zorunlu kılan bir sınırlama ile karşı karşıyayız.

Yaşamın ayrıca soğutmaya da gereksinimi vardır. Bilgisayar çiplerinde sürekli olarak, hesaplama sırasında ortaya çıkan ısının atılması mücadelesi verilir. Yaşayan canlılar için de aynı konu önem taşır. Büyük hayvanların hacim bölü yüzey alanı (yani deri büyüklüğü) oranı yüksektir. Canlının soğutmasından sorumlu organ deri olduğundan, ısının üretildiği yer de hacim olduğundan, büyük hayvanlar kendilerini soğutmakta daha az verimli olur. İlk olarak 1930’larda Max Kleiber tarafından dikkat çekildiği üzere, Dünya’daki hayvanların kilogram başına metabolik hızı, hayvanın kütlesinin 0,25.kuvveti ile orantılı olarak azalır2. Kuşkusuz ısıtma hızı bu şekilde düşmeseydi, büyük hayvanlar gerçekten de kendi kendilerini pişirirdi. Bir memelinin yaşamını sürdürebilmesi için gözlemlenen minimum metabolik hız, nanogram başına bir watt’ın trilyonda biri kadar olduğundan3, ısısal açıdan sınırlandırılmış bir maksimum organizma büyüklüğüne ulaşıyoruz: 1 milyon kilogramdan biraz fazla. Bu da yaklaşık olarak mavi balina kadar olmak demektir. Yani tam da Dünya büyüklük rekorunu elinde tutan hayvan kadar…

İlkesel olarak daha büyük yaratıklar hayal edilebilir. Eğer Landauer’in hesaplama için gereken minimum enerjiyi tanımlayan ilkesini hesaba katar ve sadece hücrelerini çoğaltmaya adanmış olan ultra-kütleli, ultra-tembel bir çok hücreli organizma olduğunu varsayarsak, mekanik desteğin ısı taşınımını aşması sorunlarının büyümeyi sınırlayan nihai etken olduğunu görürüz. Bu ölçeklerde böyle bir canlının ne yapacağı ya da nasıl evrilebileceğini de tahmin etmek mümkün değil.

Charles ve Ray Eames’in klasikleşmiş kısa filmleri “10’un Kuvvetleri” (Powers of Ten) 40 yıl kadar önce yayımlanmış ve insanların büyüklükleri kavrayışında derin etkileri olmuştur. Aşağıdaki videoda bu çalışmayı izleyebilirsiniz.

Kaynak:

- Bilimfili,

- Nautilus, “Can a Living Creature Be as Big as a Galaxy?”

< http://nautil.us/issue/34/adaptation/can-a-living-creature-be-as-big-as-a-galaxy >

Notlar:

[1] Koch, G.W., Sillett, S.C., Jennings, G.M., & Davis, S.D. The limits to tree height. Nature 428, 851-854 (2004).

[2] Kleiber, M. Body size and metabolism. Hilgardia: A Journal of Agricultural Science 6, 315-353 (1932).

[3] West, G.B., Woodruff, W.H., & Brown, J.H. Allometric scaling of metabolic rate from molecules and mitochondria to cells and mammals. Proceedings of the National Academy of Sciences 99, 2473-2478 (2002).

Bilim İnsanlarını 120 Yıldır Uğraştıran Biyoloji Problemini Bir Bilgisayar Çözdü!

- Science Alert

- Daniel Lobo, Michael Levin Inferring Regulatory Networks from Experimental Morphological Phenotypes: A Computational Method Reverse-Engineers Planarian Regeneration Plos Computational Biology Published: June 4, 2015http://dx.doi.org/10.1371/journal.pcbi.1004295

BİLGİSAYAR TARİHİNDE ÇIĞIR AÇAN 10+1 İCAT (4.BÖLÜM)

9. Fare

Bilgisayarlarımızın neredeyse ayrılmaz parçası olan “fare” ilk olarak 1968’de San Francisco’da düzenlenen bilgisayar konferansında sahneye çıktı. Stanford Research Institute’da insan faktörleri araştırma grubunu yöneten Douglas Engelbart (1925-2013), insanların bilgisayarlarla verimli bir şekilde çalışabilmeleri için geliştirdiği yeni teknikleri kuru bir konuşma yerine canlı bir gösteriyle sunmaya karar vermişti. Önceden hazırlanmış bir terminalin başına oturdu ve mikrodalga TV bağlantısıyla 50 km uzaktaki laboratuvarında bulunan bilgisayarla bağlantı kurdu. Terminale harcıalem bir klavyenin yanı sıra, alışılmadık bir araç iliştirilmişti: Arkasından kuyruk gibi bir kablo çıkan bir kutucuk.

Prototip fare Douglas Engelbart’ın elinde. (Wikipedia)

Engelbart, görüntüsünden dolayı “fare” adını verdikleri bu işaretleme cihazını kullanarak uzaktaki bilgisayarda basit bir kelime işlemci, basit bir hipermetin belgesi (bağlantılara tıklayarak başka belgelere ulaşma imkânı veren bir belge), ve başka etkileşimli yazılımlar çalıştırdı.

Dinleyicilerin ne kadarı farkındaydı bilinmez, ama Engelbart onlara geleceğin bilgisayarını göstermişti.

Fare deyip geçmemek gerekiyor. Fare, veya daha genel bir terimle “işaretleme cihazları”, büyük bir vizyonun, bilgisayar teknolojisinin insan zihnine eklemlenmesi tasarısının bir parçasıydı. Bu vizyonu ilk ifade eden kişi, bir psikolog olan ama ömrünü bilgisayar sanayiinin içinde geçirmiş olan Joseph Carl Robnett Licklider (1915-1990) idi.

Licklider disiplinlerarası çalışma için doğmuş biriydi. Matematik, fizik, ve psikoloji alanında üç lisans diploması alıp psikolojide yüksek lisans yaptıktan sonra uzmanlıklarını birleştirebildiği psikoakustik (seslerin algılanması) alanında doktora yaptı. 1950’de MIT’de elektrik mühendisleri için bir psikoloji programı oluşturdu. 1957’de yüksek teknoloji şirketi Bolt, Beranek & Newman’da başkan yardımcısı olarak çalışmaya başladı. 1960’da yayınladığı “İnsan-Bilgisayar Simbiyozu” başlıklı makalesinde insanların hayatlarının bilgisayarlarla içiçe geçtiği bir gelecek tasvir etti, ki o dönemdeki bilgi işleme usulü bu hayalin çok uzağındaydı.

- C. R. Licklider (Wikipedia)

1958’de ABD Savunma Bakanlığı’nın desteklediği DARPA (Defense Advanced Research Projects Agency – Savunma İleri Araştırma Projeleri Kurumu) tesis edildi. 1962’de Licklider DARPA’nın Bilgi İşleme Teknikleri Dairesi’nin başına geldi. İsmine rağmen DARPA doğrudan savunma projelerinden ziyade, kısa vadede uygulaması olmayan araştırmaları destekliyordu. Böylece Licklider’ın hayal ettiği şekilde bilişimi insanlarla birleştirecek araştırmalara kaynak sağlama imkânı doğdu. Engelbart’ın araştırmaları da DARPA’dan mali destek almıştı.

Fare güzel bir oyuncak olabilir, ama neden çığır açan bir buluş olsun? Elbette tek başına farenin pek faydası yoktu, ama fare bir grafik arayüzün parçasıydı, bu da radikal derecede farklı bir kullanım tarzı demekti. O zamana kadarki bilgisayar kullanımı çok üst seviyede bir soyutlama ve komut ezberleme gerektiriyordu. Oysa işaretleme cihazları, grafik arayüzlü bilgisayarların insan beyninin en kuvvetli özelliklerinden biri olan el-göz koordinasyonu ile yönetilmesini sağlıyordu. Böylece bilgisayar kullanımının insanileşmesi, kolaylaşması, kitlelere uygun hale gelmesinin kapısı aralanmıştı. Engelbart insan-bilgisayar etkileşimi denen araştırma alanına öncülük etmişti. Bugün kullandığımız grafik arayüzlerin temel prensipleri o dönemde belirlendi.

Ne var ki, Engelbart’ın sunumu kısa vadede hakettiği ilgiyi görmedi. Bilgisayar donanımı pahalıydı, yüzbinlerce dolarlık bir bilgisayarın işlem kapasitesinin bir kısmını grafik işlemleriyle harcamak makul değildi. Ancak 1970’lerde elektroniğin ucuzlaması ile işler değişti. Güçlenen ve ucuzlayan bilgisayarlarda, grafik arayüz teknolojisi sıçraması beklenmedik bir yerden, bir fotokopi makinesi üreticisinden geldi.

Xerox şirketi, yükselen Japon firmalarının rekabeti karşısında ürünlerini çeşitlendirme isteğiyle, 1969’da bilgisayar konusunda çalışacak bir ar-ge bölümü kurmuştu. Palo Alto Research Center (PARC) olarak bilinen bölümün amacı “geleceğin ofisi”ni kurmaktı. PARC’ın başına eski bir DARPA yöneticisi olan Robert Taylor (1932-) getirildi. Taylor, Licklider’la beraber çalışmıştı ve onun vizyonunu PARC’a taşıdı. Bu vizyonu Alto adı verilen bir bilgisayar sistemi üreterek somutlaştırdılar.

1973’de hazırlanan Alto çağının çok ötesinde bir bilgisayardı. Herşeyden önce, bir mainframe değil kişisel bir bilgisayardı. Bir dosya kâğıdı büyüklüğünde, dik duran ekranı grafik çıktıya uygun olarak hazırlanmıştı. Fare aracılığıyla bir grafik arayüzle çalışılıyordu. Alto’lar birbirlerine Ethernet standardı kullanan bir ağla bağlanabiliyorlardı. Alto’ları lazer yazıcılarla kullanmak da mümkündü.

Xerox Alto bilgisayarı. (Wikipedia)

Xerox Alto bilgisayarı. (Wikipedia)

Yaklaşık bin adet Alto üretildi, fakat bunlar satışa sürülmeyip Xerox içinde kullanıldılar. Henüz kişisel bilgisayar devrimine birkaç yıl vardı, ve çoğu insan koca bir bilgisayarın tek kişinin kullanımına adanmasını abes buluyordu. Zaten maliyeti 18 000 doları bulan bir kişisel bilgisayarın alıcı bulması çok zordu. Kişisel bilgisayar pazarının açılmasından sonra 1981’de ticari bir model hazırlandı ve Xerox Star adıyla piyasaya sürüldü. Ancak, çok üstün teknik özelliklerine rağmen çok yüksek fiyatı ve şirketin pazarlama başarısızlığı yüzünden piyasada tutunamadı.

Yine de Alto bilgisayar tarihini dolaylı yoldan etkiledi. 1979’da Steve Jobs PARC’ı ziyaret ettiğinde Alto’yu inceledi ve hayran kaldı. Fare ve grafik arayüz kullanımının bilgisayarların yaygınlaşmasının anahtarı olacağını tahmin etti ve yeni Apple modellerinin tasarımını buna göre yönlendirdi. Lisa adlı başarısız bir modelden sonra 1984’de ünlü Macintosh piyasaya çıktı. PC dünyasında aynı gelişme birkaç yıl sonra Microsoft’un Windows yazılımı ile sağlandı.

Fare çoğu insanı yıldıran siyah komut ekranını ortadan kaldırdı ve daha çok kullanıcının bilgisayara ısınmasına vesile oldu. Grafik arayüz görsel ve daha anlaşılır bir çalışma ortamı sağladı. Zamanla fareler gelişti, kolay bozulan toplu fareler yerine dayanıklı ve hassas optik fareler gelişti. Sürükleme topu (trackball) ve dizüstü bilgisayarlardaki touchpad gibi alternatif işaret cihazları icat edildi. Artık akıllı telefon ve tabletler ile sadece dokunmatik ekranlarıyla, yani işaretleme ile etkileşim kuruyoruz. Masaüstü bilgisayarların yakında yerlerini mobil cihazlara bırakacağı söyleniyor. Yakında bilgisayarlarla bilimkurgu filmlerindeki gibi boşlukta el hareketleri ile etkileşmeye başlayabiliriz. Bütün bunlar 45 yıl önce Douglas Engelbart’ın elindeki gösterişsiz tahta kutunun içinden çıktı.

“Azınlık Raporu” filmindeki gibi el hareketleriyle yönetilen bilgisayarlar çok uzak değil.

10. Web 2.0

Son maddeye başlamadan önce bir durup, çığır açıcı bulma kriterlerimizi gözden geçirelim.

Başka icatları yaratan bir kök icat, çığır açıcı olarak düşünülebilir. “Y olmasa Z olmazdı, X olmasa da Y olmazdı” mantık zinciriyle gidebildiğimiz kadar geriye giderek bir alandaki en önemli icadı bulabiliriz. Ama bunda iki sorun var. Birincisi, icatlar genellikle birden fazla kaynaktan beslenirler, doğrusal bir çizgi takip etmezler, hatta bazen birbirlerini aynı anda geliştirirler. İkincisi de, hiç bir icat gökten inmediği için, bu zincirin sonunda nihai çığır açıcı icat olarak “ateş yakma”ya varırız. Bu kadar geriye gitmek de abes olur elbet.

Bu listedeki icatları seçerken mihenk taşım şu oldu: Daha önceki teknolojilerden ciddi şekilde farklı olan inovasyonlar (meselâ transistörler), veya varolan teknolojileri biraraya getiren, büyük bir inovasyon içermeyen, ama öngörülemeyen büyük sonuçlar yaratanlar (meselâ kişisel bilgisayarlar).

Büyük bir sonuç olarak önümüzde bilgisayar ağları var. Hayatımızın her alanına entegre olmuş durumda. Peki, “ağ toplumu”nun çığır açıcı adımı nerede atıldı?

Teknoloji olarak bakıldığında bu adımın, yukarıda bahsettiğim DARPA kurumunun fonlarıyla desteklenen ARPANET projesi ile atıldığı söylenebilir. 1960’ların başında tasarlanmaya başlayan ve 1970’de devreye giren ARPANET’in amacı, coğrafi olarak birbirinden uzak mainframe bilgisayarları iletişim hatlarıyla birbirine bağlamaktı. Bu sayede bir bilgisayarın yoğun olduğu durumlarda iş yükünü başka bir bilgisayara aktarmak, böylece kaynakların daha ekonomik kullanılmasını sağlamak amaçlanıyordu.

ARPANET’i oluşturmak kolay olmadı. O dönemin birbirinden çok farklı iç yapıya sahip ve değişik veri kodlama usülleri olan bilgisayarlarının kullanabileceği güvenilir bir platform yaratmak gerekiyordu. Bu amaçla, verilerin parçalara bölünüp ağ üzerinden gönderilmesi, kaynaktan hedefe doğrudan bağlantı yoksa aradaki bilgisayarların veriyi yönlendirmesi gibi yöntemler geliştirildi. Ağdaki bilgisayarların iletişim kurma kurallarını belirleyen “protokol”ler, TCP (Transmission Control Protocol – İletim Yönetimi Protokolü) ve IP (Internet Protocol – Ağlar arası protokol), yine ARPANET himayesinde gelişti. Bugünkü internet altyapısı hâlâ bu teknolojilerin üzerinde durduğu için ARPANET’in çığır açıcı olduğu söylenebilir.

ARPANET’in 1971 yılı itibariyle kapsamı. (Richard Griffiths)

Başka bir açıdan bakıldığında ise asıl büyük adımın Ethernet teknolojisi olduğu söylenebilir. Bu teknoloji 1973’de, Xerox PARC’da Alto bilgisayarı ile beraber geliştirildi. Buradaki amaç yerel olarak bağlı bilgisayarların bilgi alışverişi yapmasını sağlamaktı. Bir ofiste veya laboratuvardaki bilgisayarlar ortak bir aktarım kablosuna bağlanır, ve her biri diğerine sinyalleri aynı hat üzerinden gönderir. Sinyallerin karışmasını engellemek için, bir odadaki sohbette insanların kullandığı nezaket protokolüne benzer kurallar uygulanır. Sözgelişi, her bilgisayar iletişimi dinler, kanal boşsa kendi sinyalini gönderir. İki bilgisayar aynı anda sinyal gönderdiyse ikisi de durur, rastgele bir süre sonra tekrar denerler.

ARPANET birbirinden uzak ana bilgisayarlar arasında çalışan bir iletişim omurgasıydı, Ethernet ise yakın mekândaki kişisel bilgisayarları bağlayan bir yerel ağ oluşturuyordu. Birbirini tamamlayan bu iki teknoloji 1970’lerde ortak protokollerde birleşti ve bu protokoller bugüne kadar geldi. Bu yazıyı okuduğunuz bilgisayar Ethernet kurallarına göre çalışan bir devreyle ağınızın “router”ına bağlandı, o da TCP/IP kurallarıyla Açık Bilim sunucusundan bu sayfayı talep etti, ve sizin bilgisayarınıza aktardı.

Ancak, fiziksel bir ağ yapısı o kadar da orijinal bir fikir değildi. İletişim ağı olarak telefon şebekesi örneği vardı. Hatta önceki yüzyılda geliştirilen telgraf şebekesi bile “Victoria devri interneti” olarak anılmayı hakedecek derecede yoğun bir bilgi aktarımı sağlamıştı. Bu yüzden, biraz da cüretkâr davranarak, çığır açıcı olan gelişmenin bağlantı kurabilmek değil, aktarılan bilgilerin anlamlı şekilde organize edilmesi olduğunu savunacağım.

1980’lerde, varolan internet altyapısı üzerinde çeşitli bilgi alışverişi yöntemleri gelişti. Dosya paylaşımı, e-posta, ilan tahtası sistemleri (BBSler), listserv haberleşme grupları gibi. Bunlar küçük meraklı gruplarına hitap ediyordu, geniş kitlelere yayılmamıştı (kişisel bilgisayarların ilk aşamalarının da böyle olduğunu geçen ayki yazıdan hatırlarsınız).

World Wide Web beklenmedik bir yerden çıkageldi. 1990’da, İsviçre’deki uluslararası yüksek enerji fiziği laboratuarı CERN’de çalışan İngiliz fizikçi ve yazılım mühendisi Tim Berners-Lee (1955-), değişik bilgisayarlara dağılmış verilerin, hipermetin tıklamalarıyla birleştirilebileceği bir belge sistemi tasarladı ve Belçikalı yazılım uzmanı Robert Cailliau (1947-) ile işbirliği yaparak geliştirdi. Her Web adresinin başında gördüğünüz http (HyperText Transfer Protocol – Hipermetin Aktarma Protokolü) ve web sayfalarının görüntülenmesi için kullanılan kodlama dili HTML (Hypertext Markup Language – Hipermetin İşaretleme Dili), Berners-Lee tarafından icat edildi.

Tim Berners-Lee. (World Wide Web Foundation)

WWW kısa zamanda CERN sınırlarını aştı ve dünya çapında bir bilgi paylaşımı sistemi haline geldi. Berners-Lee’nin 1991’de yaptığı bir konferans sunumundan sonraki iki yıl içinde Web standardıyla hazırlanmış belgelerin sayısı hızla arttı. Berners-Lee Web yapısının ticari sır haline getirilmemesi, herkese açık bir geliştirme platformu olmasını istiyordu; CERN’i Web teknolojisini halka açmaya ikna etti.

İlk yıllarda Web sayfalarına metin temelli tarayıcılarla (örneğin Lynx) erişiliyordu. 1990’ların ortalarında iki gelişme Web’in akademik çevrelerden topluma hayata yayılmasını sağladı. Birincisi, 1994 sonunda hazırlanan grafik arayüzlü Netscape tarayıcısıydı. Netscape ile Web sayfalarında resim, müzik ve video gösterilebiliyor, sayfa düzeni şık bir şekilde düzenlenebiliyordu.

İkinci önemli gelişme Web’in ticarileşmesiydi. ARPANET ve 1990’da onun yerine geçen NSFNET internet omurgalarının masrafları ABD hükümeti tarafından karşılandığı için ticari amaçla kullanılmaları yasaktı. 1995’de NSFNET kapatıldı, yerini o zamana kadar serpilmiş özel internet servis sağlayıcıları aldı. Böylece mal ve hizmet satan kâr amaçlı Web siteleri kurulabildi ve e-ticaret hacmi hızla arttı. Ticarileşmeyle beraber Web sayfalarının profesyonelliği arttı, programcılar gitgide daha güzel görünen sayfalar hazırlamayı, ve karmaşık bilgilerin organize edilebildiği site düzenleri kurmayı öğrendiler.

Web’in ani patlamasının hikâyesini hepimiz biliyoruz. Ne oldu demeye kalmadan Web, banka işlemlerimiz, alışverişimiz, haberleşmemiz ve sosyalleşmemizde merkezi duruma geldi.

O zaman, Tim Berners-Lee’nin aklının ürünü olan WWW’nin çığır açıcı olduğunu söylemek doğru olur. Bununla beraber, 2000’lere gelene kadarki Web ile, son on yılın Web’i arasında büyük farklar olduğu da iddia edilebilir.

2000’lerin başında Web sayfalarının altyapısında olmasa da, görünüşü ve kullanılışında radikal bir değişiklik yaşandı. Eskinin statik (her açılışta aynı kalan, yeni içeriğin ancak sayfa tasarımcısı tarafından eklenmesiyle görülebilen, zayıf etkileşimli) Web sayfalarının yerini dinamik sayfalar aldı. Bu siteler kullanıcıya özel şekilde oluşturulabiliyor, anlık değişiklikleri gösterebiliyor, içinde başka uygulamaları barındırabiliyordu. Bu yeni yaklaşıma, yazılım sürümlerinin numaralanmasından ilham alarak, Web 2.0 adı yakıştırıldı.

Web 2.0 kavramı teknolojik altyapıda fazla bir değişiklik içermez. Bitler ağ üzerinde kırk yıllık TCP/IP protokolüyle aktarılır, web uygulamaları HTTP protokolüyle açılır, sayfalar HTML sayfalarıyla görüntülenir ve 1990’larda kullanılan aynı programlama dilleriyle programlanır. Asıl önemli fark, bu sayfaların sunduğu hizmetlerdedir.

1990’ların Web’i (“Web 1.0”) çok önemli bir devrim yapmış, isteyen herkesin kendi web sayfasını oluşturabileceği araçlar sunmuştu. Yine de bu araçlar belli bir teknik zorluğa göğüs germeyi gerektiriyordu, sayfayı barındıracak bir internet hizmeti (“hosting”) ve alan ismi satın almak, HTML kodlaması yapmak gibi. Bireylerin söz hakkı bir miktar artmıştı, ama ifadenin önündeki bariyerler tamamen kalkmamıştı.

Web 2.0 ise kişiler arası bağlantıları, iletişimi, ortak çalışmayı, içerik üretimini ön planda tutar. Sözgelişi, Web programlama zahmetine girmek istemeyenler ücretsiz olarak, hazır kalıpların bulunduğu Web alanları oluşturabilirler. Bunlar statik sayfalar da olabilir, bloglar gibi belli usullerde dinamik hizmet veren siteler de. “İçerik yönetim sistemleri” denen üst düzey Web programlama araçları, tam teşekküllü bir site oluşturmayı çok kolay hale getirerek site sahibinin, yazacağı içeriğe odaklanmasını sağlıyor.

Web 2.0 uygulamaları iki boyutta, içerik paylaşımından paylaşma/filtrelemeye, ve Web uygulamasından sosyal ağa, değişik noktalarda yer alırlar. (Future Exploration Network)

Web 2.0 uygulamaları iki boyutta, içerik paylaşımından paylaşma/filtrelemeye, ve Web uygulamasından sosyal ağa, değişik noktalarda yer alırlar. (Future Exploration Network)

Örnek vermek gerekirse, son yılların belki de en büyük uygarlık adımı olan Wikipedia “wiki” adı verilen özel bir içerik yönetim sistemi kullanır. Ama ne okuyucuların, ne de madde yazarlarının bunun ayrıntısını bilmesi gerekmez. Bazı basit kuralları kullanarak içerik yaratmak esastır. Wikiler ve benzeri internet imecelerinin (“crowdsourcing”) devrimsel yanını anlatmak buraya sığmaz. Web 2.0’ın sağladığı araçların temel yararını Clay Shirky’nin ifadesiyle şöyle özetleyebiliriz: “Bir örgüt olmanın minimum maliyeti nispeten yüksek olduğu için, bazı faaliyetler, belli değerleri olsa da, örgütlü şekilde yürütülmeye değecek kadar değerli değildirler. Yeni sosyal araçlar, grup eylemini koordine etmenin maliyetini düşürerek bu denklemi değiştirir.”

Sosyal ağlar, Facebook, Twitter, FriendFeed, LinkedIn, Google+, ve daha niceleri, Web 2.0 kapsamındaki araçlar ve kavramlar ile ortaya çıktı. Bunlar bireylere hızlı ve ücretsiz olarak içerik üretme imkânı vermekle kalmadı, paylaşma ve tartışma ortamı da doğurdu. İfade bariyerleri daha da aşağı indi.

Sosyal ağlar toplumsal ve siyasi değişimde de kilit rol oynuyor. Eskiden kolayca örtbas edilen kabahatler sosyal medyada fırtına gibi esiyor, hafızalara yerleşiyor. İletişimin kolaylaşmasıyla örgütlenme imkânı artıyor, Arap Baharı veya Gezi Direnişi gibi kitle hareketleri bir anda ortaya çıkıveriyor.

Coursera, EdX, KhanAcademy gibi sitelerin sunduğu çevrimiçi dersler, geleneksel eğitimi ortadan kaldırmasa bile, muhtemelen değişik bir biçime sokacak. Yeni Web araçları bilimsel araştırmaya da damgasını vuruyor; eski yayıncılık modeli değişiyor, makalelerin “müsvedde”lerini barındıran arşivler en çok kullanılan yayın mecraı haline geldi. Bilimsel araştırmanın her aşamasının paylaşılmasından bahsediliyor.

Web 2.0, bilgiye bakışımızı kökten değiştirdi. Eski medyada gazeteler, basılı ansiklopediler, televizyonlar, tek yönlü ve tartışmasız bir otorite oluştururlardı. Yeni medya ise bunların çoğunun üzerinden atlayıp geçiyor. Tek taraflı değil, kişilerin karşılıklı tartışmaları ve paylaşmalarından ortaya çıkan yeni bir resim çiziyor. Bu yeni tavır, eskiye alışık olanların tepkisini çekiyor. Sosyal ağlarda yayılan yalan haberleri ve abartıları kötü örnek olarak göstermek yaygın, fakat buna karşılık geleneksel medyada da yalanlar ve çarpıtmaların çok sayıda olduğunu gördük, özellikle de Gezi direnişi ve daha sonraki olaylarda. Web 2.0 araçlarını kullandıkça görüyoruz ki, kitlesel katılımla hazırlanan içerikte, Wikipedia sayfası olsun, twitter haberleri olsun, gerçeğin daha kapsamlı ve doğru bir ifadesine ulaşmak mümkün.

Toplum hayatında devrim yaratan kişisel bilgisayarların bir teknolojik atılımdan çok, varolan teknolojinin farklı bir kullanım tarzı olduğunu görmüştük. Aynı şekilde Web 2.0 da, mevcut yazılım ve donanım sistemlerinin kitlesel kullanıma uygun hale getirilmiş paketlemelerinden başka birşey olmasa da, hayatımızda olağanüstü değişiklikler yaptı ve yapmaya devam ediyor.

11. İkili sistem

“Dünyada 10 çeşit insan vardır: İkili sistemi bilenler ve bilmeyenler.” – Anonim

Buraya kadar, aşağı yukarı kronolojik sırayla, on değişik çığır açıcı teknoloji gördük. Bunların bir kısmı diğerlerine temel oldu, bir kısmı varolanların değişik bir bakış açısıyla kullanılması ile gerçekleşti.

Ancak açıkça görünür olmasa da bütün bilgisayar teknolojisinin altında yatan bir teorik kavram var: Bilgiyi ikili sistemde, sıfırlar ve birler dizisi olarak kodlamak ve işlemek. Bilişim teknolojisi tamamıyla bu matematiksel teorinin görünmez temeli üzerinde durur.

İkili sistemde yazılan her işaret bir bit (“binary digit” – ikili rakam) olarak anılır ve sadece 0 veya 1 değerlerini alır. 1950’lerden bu yana bütün bilgisayarlar ve diğer dijital araçlar bilgiyi bitler dizisi olarak saklar, kullanır ve aktarır. Ancak eski bilgisayar tasarımlarının hepsi ikili sistem kullanmıyordu. Howard Aiken’in Harvard Mark I cihazı (1943), hatta daha sonraki ENIAC (1946) bile sayıları onlu tabanda saklıyor ve işliyordu. Daha öngörülü tasarımlar olan Konrad Zuse’nin mekanik Z1 (1937) makinesi ile, John Atanasoff ve Clifford Berry’nin lambalı ABC’si (1942) ikili tabanda çalışıyorlardı.

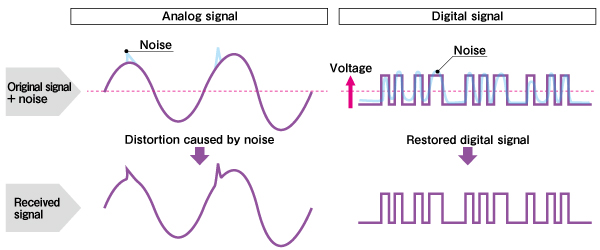

Bitler ve ikili sistem neden bu kadar önemli? Biri teknik, biri matematiksel olmak üzere iki sebebi var. Teknik sebep, ikili sistemde kodlanmış verilerdeki aktarımındaki hataların ortadan kaldırılabilmesinin kolay olması. Sözgelişi, antenle dinlediğimiz radyo ile, Açık Bilim’in cepyayınını karşılaştıralım. Birincisi radyo vericisinden aktarılan analog sinyallerle bize ulaşır. Radyoda ses, radyo dalgasının frekansının an be an küçük miktarlarda değiştirilmesiyle kodlanır. Ancak etrafımızı saran başka elektromanyetik dalgalar da vardır: Başka radyo kanalları, TV veya telsiz yayınları, cep telefonu sinyalleri, az da olsa evimizdeki ampullerden çıkan radyo dalgaları, hatta şimşekler. Bu dalgaların bazıları alıcımızda sinyale karışır ve sinyali az da olsa değiştirir. Radyodaki “parazit”in sebebi budur. Antenli televizyonlarda aynı etki kumlu görüntü olarak kendini belli eder.

Açık Bilim’in cepyayınındaki ses ise ikili sistemde kodlanmıştır. Bu kodlamada ses dalgasından sık aralıklarla “numune” alınır, ve her numunedeki dalga büyüklüğü ikili sistemde (genellikle çok sayıda bitle) ifade edilen bir sayıya dönüştürülür. Bunlar arka arkaya eklemlenerek dijital ses dosyasını oluştururlar (genellikle de dosya boyunun küçülmesi için sıkıştırma uygulanır).

Dijital bilgi aktarılırken de elbette yukarıda saydığım elektromanyetik parazit yine sinyale eklenir. Ancak, genellikle parazit dijital sinyalin 0 ve 1’lerini ayıran aralıktan daha zayıftır. Dijital alıcı belli bir eşiğe kadar olan dalgalanmaları düzeltebilir, meselâ 0.7 değerini 1 olarak, 0.2 değerini 0 olarak alır. Bu yüzden parazit, çok kuvvetli olmadıkça, dijital sinyali bozmaz.

Solda: Bir analog dalgaya parazit eklendiğinde sinyal bozulur. Sağda: Bir dijital sinyale eklenen parazit alıcının aldığı sinyali değiştirmez. (Yamaha Corp.)

Solda: Bir analog dalgaya parazit eklendiğinde sinyal bozulur. Sağda: Bir dijital sinyale eklenen parazit alıcının aldığı sinyali değiştirmez. (Yamaha Corp.)

Aynı avantaj kopyalamada da geçerlidir. Analog kayıt yapan eski tip bir manyetik teyp kasetini başka bir kasete kopyaladığınızda az da olsa bazı sesleri kaybedersiniz. Kopyanın kopyasını yaparsanız biraz daha bilgi kaybedersiniz. Dijital kopyalamada ise, hem dijital sinyalin ayrıklığından, hem de çeşitli hata düzeltme algoritmaları kullanıldığından, bilgi kaybı yok denecek kadar azdır.

Teknik avantajının yanı sıra ikili sistem, dijital devrelerin temel matematik ile tasarlanıp analiz edilmesine de elverişlidir. Bitler 1-0 yerine bazen doğru-yanlış veya evet-hayır şeklinde de yorumlanırlar. Bu onları, temel önermeler mantığına bağlar. Önermeler de bitler gibi iki değerlidir, ya doğrudurlar ya yanlış, üçüncü bir şık yoktur. Önermelere ve, veya, değil gibi işlemler uygulanarak yeni önermeler üretilebilir. Karmaşık mantık işlemleri, Boole cebrinden türetilen bazı bağıntılarla basitleştirilebilir.

Bu matematiksel/mantıksal kavramlar dijital elektroniğe birebir aktarılabilir. İkili veriler, bunlarla ve, veya, değil işlemi yapan elektronik devrelere (mantık kapıları) bağlanır. Mantık kapıları ise birleştirilerek aritmetik, bellek erişimi, veri saklama gibi işlemler yapan devrelere dönüştürülebilir. Bunların hepsinin işleyişi Boole cebri ile analiz edilebilir. Dahası, devre tasarımı ve analizi bu matematiksel araçlar yardımıyla otomatik hale getirilebilir, yani devre tasarımı yapan programlar üretilebilir.

Bugünkü bilgisayar devrimimizin kökü temel matematikten beslenir. Eğer verileri ikili sistemle kodlamasaydık elektronik parazit gibi teknik bir sorunu aşmamız belki yine mümkün olurdu, ama devreleri temel mantık ve Boole cebri kullanarak analiz etmemiz mümkün olmayacaktı ve muhtemelen elektronik devreleri bugünkü karmaşıklığına ulaştıramayacaktık.

Bence bu, temel bilimlerle sağlanan bilgi birikimi olmadan teknolojik gelişmenin mümkün olmayacağını ispatlayan en güzel örneklerden biri.

Kaynaklar

- AçıkBilim

- Paul E. Ceruzzi, A History of Modern Computing, 2nd ed., MIT Press, 2003.

- Martin Campbell-Kelly, William Aspray. Computer: A History of the Information Machine, 2nd ed., Westview Press, 2004.

- Michael R. Williams, A History of Computing Technology, 2nd ed., IEEE Computer Society Press, 1997.

- Clay Shirky, Herkes Örgüt, çev. Pınar Şiraz, Optimist, 2010.

- Yamaha Corp., The Merits of Digital Sound.

- Minority Report, yön. Steven Spielberg, 20th Century Fox, 2002.

- Richard T. Griffiths, History of the Internet Chapter Two: From ARPANET to World Wide Web.

Bilgisayar devrimleri III. Bölüm

Kişisel bilgisayarların ortaya çıkışı, hem teknolojik evrimde hem de toplumsal organizasyonda en derin değişimlerden birini temsil eder. 1970’lerden önce, “bilgisayar” terimi genellikle büyük kurumlar, şirketler veya hükümetler içinde barındırılan büyük, merkezi bir makineyi ifade ediyordu. Bu ana bilgisayar veya mini bilgisayar sistemleri, özel çevre koşulları, titiz bakım ve yüksek eğitimli operatörler gerektiriyordu. Entegre devreler (IC’ler) ve yarı iletken üretim süreçleri ilerledikçe, cihaz boyutları ve maliyetleri önemli ölçüde düşmeye başladı. 1970’lerin başlarında, nispeten uygun fiyatlı bilimsel hesap makineleri daha küçük ölçekli bilgi işlem potansiyeline işaret ediyordu. Yine de, bir bireyin bir bilgisayara sahip olması ve onu işletmesi fikri (başlangıçta “mikro bilgisayar” olarak adlandırılıyordu) marjinal bir hobi arayışından küresel bir ekonomik ve sosyal dönüşümün başlangıcına ancak 1970’lerin ortalarında geçti.

Hesap Makinelerinin Rolü ve İlk Hobi Toplulukları

1960’ların sonu ve 1970’lerin başında, Hewlett-Packard, Texas Instruments, Casio ve Sharp gibi şirketlerden hesap makinelerinin ortaya çıkması, seri üretim entegre devrelerin yolunu açtı. Bu cihazlar, hesaplamayı bireysel profesyonellerin, öğrencilerin ve elektronik meraklılarının eline getirdi. 1974’te “kişisel bilgisayar” olarak tanıtılan Hewlett-Packard’ın HP-65’i, tuş vuruşlarını depolayıp tekrar oynatabiliyordu ve bu da küçük ölçekli programlamaya etkili bir şekilde izin veriyordu. Bu hesap makineleri çoğu tüketici için pahalı olmaya devam etse de, tarihçi Paul Ceruzzi’nin “hesaplama coşkusu” olarak tanımladığı şeyi başlattılar ve kişisel cihazlarda deney yapma ve problem çözme kültürünü teşvik ettiler.

Hesap makinesi meraklılarına paralel olarak, amatör radyo ve elektronik meraklıları (genellikle Popular Electronics ve Radio-Electronics gibi dergiler tarafından yönlendirilirler) dijital tasarım için entegre devrelerle deneyler yapıyorlardı. İlk ticari olarak mevcut mikroişlemci olan Intel 4004’ün (genel bilgi işlem için son derece sınırlı olsa da) ve Intel 8008 (1972) ve 8080 (1974) gibi haleflerinin gelişi, tamamen yeni dijital cihazlar üretmeye meyilli olanlar için modüler bir temel sağladı.

Altair 8800 ve Kişisel Bilgisayar Çağının Doğuşu

Bu arka plana karşı, Albuquerque’deki MITS (Mikro Enstrümantasyon ve Telemetri Sistemleri), 1975’te Altair 8800 kitinin piyasaya sürülmesiyle ün kazandı. Intel’in 8080’ine dayanan Altair, klavyesi, ekranı ve son derece sınırlı belleği olmamasına rağmen, hobi pazarı için uygun fiyatlı, genel amaçlı bir bilgisayarın uygulanabilirliğini gösteren, posta yoluyla sipariş edilen, kullanıcı tarafından monte edilen bir bilgisayardı. Cihazın Ocak 1975’te Popular Electronics dergisinin kapağında tanıtılması bir zincirleme tepkiye yol açtı. Kullanıcılar hemen Altair’i delikli bant okuyucular, ek bellek kartları ve hatta disket sürücüleri gibi çevresel aygıtlarla genişletmeye çalıştılar. Önemli bir şekilde, Bill Gates ve Paul Allen’ın BASIC yorumlayıcısıyla örneklenen yazılım geliştirme, donanım hareketiyle paralel olarak ortaya çıktı ve programlamanın kurumsal olmaktan çok bireysel bir çaba olabileceği fikrini oluşturdu.

Apple ve Mikrobilgisayarın Genişlemesi

Aynı dönemde, Silikon Vadisi’ndeki Homebrew Bilgisayar Kulübü meraklılar için bir kuluçka merkezi görevi gördü. Bu canlı topluluk içinde, Steve Wozniak ve Steve Jobs 1976’da Apple I’i bir araya getirdi ve ticarileştirdi. Hala ayrı olarak elde edilen bir klavye, monitör, güç kaynağı ve kasa gerektiren bir devre kartı olmasına rağmen, Apple I tamamen hobi amaçlı kitlerden daha kullanıcı dostu idi. Apple I’in mütevazı başarısından cesaret alan Apple Computer, 1977’de Apple II’yi tanıttı. Bu makine, yalnızca elektronik deneycilere değil, genel tüketici kitlesine yönelik ilk “tak ve çalıştır” kişisel bilgisayarlardan biriydi. Tam özellikli tasarımı ve ardından 5¼ inçlik disket sürücüsünün piyasaya sürülmesi, en ünlüsü ilk yaygın elektronik tablo uygulaması olan VisiCalc olan büyüyen bir yazılım kütüphanesinin ortaya çıkmasına neden oldu. Birçok kişi için VisiCalc, kişisel bir bilgisayar satın almayı haklı çıkardı ve özel bir hobi nesnesinden temel bir iş ve üretkenlik aracına geçişi gösterdi.

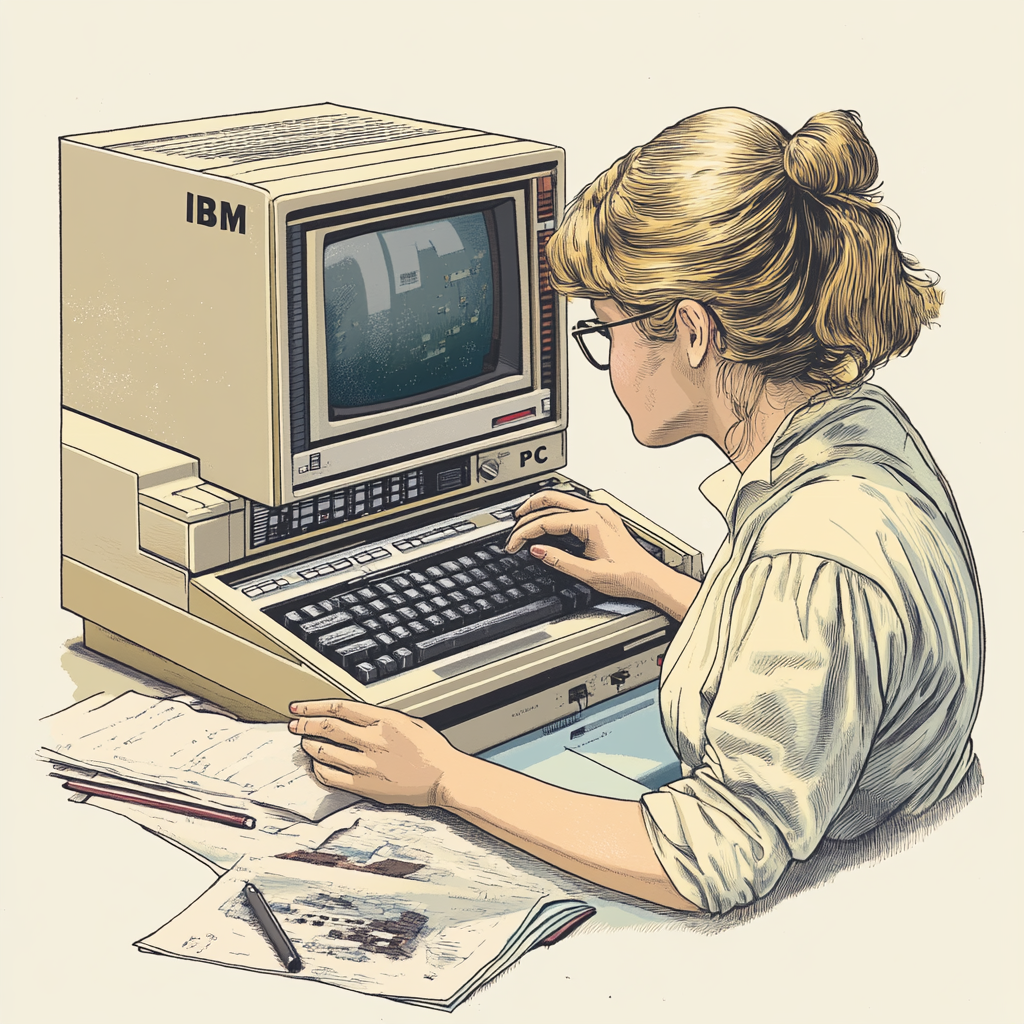

IBM ve PC’nin Standardizasyonu

Tarihsel olarak ana bilgisayarlar ve iş odaklı bilgi işlemdeki hakimiyetiyle bilinen IBM, ilk olarak 1975’te 5100 ile mikrobilgisayar sularını test etti. Sınırlı satışlara rağmen IBM, 1980’de mikrobilgisayarların (yeniden markalanmış “kişisel bilgisayarlar”) iş ve ticari operasyonları yeniden şekillendirmeye hazır olduğunu fark etti. Bu fırsatı hızla değerlendirmek için IBM, 1981’de tanıtılan IBM PC olarak daha iyi bilinen IBM Model 5150’yi geliştirmek üzere küçük ve nispeten özerk bir ekip (“Project Chess” olarak adlandırıldı) kurdu. Intel’in 8088 mikroişlemcisini seçerek IBM, Microsoft’un MS-DOS işletim sistemiyle birlikte piyasadaki en hızlı sistemlerden birini sundu. IBM adının anında itibar kazanması, kurumsal ortamlarda kişisel bilgisayarları etkili bir şekilde meşrulaştırdı, ilk üretim tahminlerini aşan talebi teşvik etti ve bir endüstri standardı haline gelecek mimarinin oluşturulmasına yardımcı oldu.

Microsoft, DOS ve Uyumlulukların Yükselişi

Microsoft’un IBM PC ile ilişkisi, Digital Research’ün IBM’in bir işletim sistemi için yaptığı sözleşmeyi reddetmesinden sonra başladı. 30.000 dolara satın alınan mevcut bir üründen geliştirilen MS-DOS ile Microsoft, işletim sistemini IBM’in kullanımının ötesinde bile yeniden satmasına ve haklarını korumasına olanak tanıyan kazançlı bir lisans anlaşması elde etti. Kısa süre sonra Compaq gibi şirketler, IBM’in tek gerçek tescilli öğesi olan IBM PC’nin BIOS’unu tersine mühendislikle “IBM uyumlu” makineler yaratmak için kullandılar. Compaq’ın 1982 taşınabilir PC’sini kısa sürede bir “PC klonları” dalgası izledi ve bu da donanımın meta haline gelmesine ve Microsoft’un işletim sistemlerinin dünya çapında milyonlarca makinede hakimiyet kurmasına yol açtı.

Daha Geniş Etki ve Kültürel Değişim

1975’ten 1977’ye kadar -sadece iki yıl- mikrobilgisayarlar niş hobi kitlerinden tamamen monte edilmiş, tüketiciye hazır cihazlara dönüştü. 1980’lerin başlarında, bunlar sadece hobi amaçlı kullanıcılar ve küçük işletmeler için değil, aynı zamanda ofis iş akışlarını modernize etmek isteyen büyük şirketler için de olmazsa olmaz araçlardı. IBM PC’nin ve ardından gelen uyumlularının hızlı benimsenmesi, donanım platformlarını önemli ölçüde standartlaştırdı ve yazılım geliştirme ve çevre birimi üretimi için devasa bir ekosistem oluşturdu. Apple gibi şirketler, en ünlüsü 1984’te Macintosh ve GUI’sinin piyasaya sürülmesiyle olmak üzere alternatif mimariler ve kullanıcı arayüzleri izledi ve böylece grafik tasarım, multimedya ve masaüstü yayıncılığındaki olanakları genişletti.

Sonraki on yıllarda, kişisel bilgisayarların her yerde bulunması, “bilgi özgürlüğü”nün, açık kaynak hareketinin ve büyük ölçekli bağlantının yükselişini hızlandırdı. 1990’lara gelindiğinde, Microsoft Windows ve Unix benzeri Linux dağıtımları gibi işletim sistemleri, kişisel ve kurumsal bilişimi aynı şekilde şekillendirdi. Bir zamanlar ana bilgisayar dönemi standartlarına göre önemsiz bir oyuncak olarak görülen kişisel bilgisayar, küresel iletişimin, ticaretin ve inovasyonun temel taşı haline gelmişti.

İleri Okuma

- Kidder, T. (1981). The Soul of a New Machine. Little, Brown and Company.

- Aspray, W. (1984). “The Intel 4004 Microprocessor: What Constituted Invention?” IEEE Annals of the History of Computing, 6(2), 75–79.

- Campbell-Kelly, M., & Aspray, W. (1996). Computer: A History of the Information Machine. Basic Books.

- Hiltzik, M. (1999). Dealers of Lightning: Xerox PARC and the Dawn of the Computer Age. HarperBusiness.

- Freiberger, P., & Swaine, M. (2000). Fire in the Valley: The Making of the Personal Computer. McGraw-Hill.

- Levy, S. (2001). Hackers: Heroes of the Computer Revolution (25th Anniversary ed.). Penguin.

- Ray A. Allan. A History of the Personal Computer: the People and the Technology, Allan Publishing, 2001.

- Ceruzzi, P. E. (2003). A History of Modern Computing. The MIT Press.

- Martin Campbell-Kelly, William Aspray. Computer: A History of the Information Machine. 2nd ed., Westview Press, 2004.

- Paul E. Ceruzzi. A History of Modern Computing. 2nd ed., MIT Press, 2003.

- Allen, P. (2011). Idea Man: A Memoir by the Co-founder of Microsoft. Portfolio/Penguin.

- AçıkBilim

- Wikipedia: Micro Instrumentation and Telemetry Systemshttp://en.wikipedia.org/wiki/Micro_Instrumentation_and_Telemetry_Systems

- IBM 100: Icons of Progress – The PC http://www-03.ibm.com/ibm/history/ibm100/us/en/icons/personalcomputer/

BİLGİSAYAR TARİHİNDE ÇIĞIR AÇAN 10+1 İCAT (2. BÖLÜM)

Dizimizin önceki bölümünde rölelerden lambalara, lambalardan transistörlere ve mikroişlemcilere kadar gelmiştik. Hızlı, güçlü ve elde taşınabilecek kadar küçük bilgisayarlarımız olmasını bu gelişime borçluyuz. Bu inovasyonların çalışan bilgisayarlara dönüştürülmesi, ve bu bilgisayarların toplumda yaygın olarak kullanılması ise bambaşka bir meseleydi ve kendi gelişim çizgisini izlemişti.

6. Ticari mainframe bilgisayarlar

1940’ların sonu gelirken, bilgisayarların işe yarayan cihazlar olduğu anlaşılmıştı. Gerek askeriye, gerek üniversiteler ve diğer araştırma kurumları büyük masrafları göze alarak kendi bilgisayarlarını inşa etmeye başladılar. Ancak, bilgisayarların tam potansiyeli henüz anlaşılamamıştı. İngiltere’nin Ulusal Fizik Laboratuarı’nı yöneten Sir Charles Galton Darwin (“Türlerin Kökeni” yazarının torunu) bile, 1946’da bir ülkenin ihtiyaç duyduğu bütün hesaplama problemlerinin bir tek bilgisayar tarafından çözülebileceğini söylüyordu. Bugün bu düşünce bize garip geliyor; ama o zamanlar bilgisayarların amaçlarının matematiksel tablolar oluşturmakla sınırlı tutulduğunu hatırlarsak, anlaşılabilir bir varsayımdı. “Mainframe” veya “ana bilgisayar” olarak bilinen ilk ticari bilgisayarlar bu algıyı birkaç yıl içinde kıracaktı.

ENIAC projesi tamamlandıktan sonra John Mauchly ve Presper Eckert, Pennsylvania Üniversitesi’ndeki görevlerinden ayrıldılar ve iş dünyasına yönelik bilgisayarlar üretmek amacıyla 1946’da kendi şirketlerini kurdular. Akademik dünyanın dışında vizyonlarını paylaşan neredeyse kimse yoktu. Sermaye bulmakta zorlandılar, üstelik iş yürütme konusunda çok da becerikli değillerdi. Buna rağmen Nüfus Sayımı Bürosu’yla bir anlaşma yapabildiler ve UNIVAC (UNIVersal Automatic Computer) adını verdikleri yeni bilgisayarı inşa etmeye başladılar.

Ancak UNIVAC’ın inşa edilmesi tahmin edilenden daha zor oldu. Kâğıt üzerindeki tasarımı, kolay kullanılan bir cihaza dönüştürmek -özellikle de hazır bileşenlerin yokluğunda- olağanüstü bir mühendislik çabası gerektiriyordu. Proje teslim tarihleri hep gecikti, yine de şirket birkaç yeni siparişin avansı ile ayakta durabildi. İnişli çıkışlı dört yılın ardından, mali sorunlar yüzünden Mauchly ve Eckert şirketlerini Remington Rand’e satmak zorunda kaldılar. Ancak projeden ayrılmadılar, Remington Rand çalışanı olarak UNIVAC’ı geliştirmeye devam ettiler.

UNIVAC 1952’deki ABD başkanlık seçimleri sırasında popüler kültüre yerleşmeyi başardı. Remington Rand, CBS televizyon kanalıyla seçim sonuçlarını tahmin etmek üzere anlaştı. Kilit eyaletlerden gelen kısmi seçim sonuçlarını istatistiksel olarak işlemek üzere bir program hazırlandı ve seçim gecesi canlı yayında işe başladı. Asıl iş UNIVAC merkezinde yapılıyordu, stüdyoya dekor olsun diye içi boş bir UNIVAC kutusu kurulmuş, içine yanıp sönen Noel ışıkları döşenmişti. Sonraki yıllar boyunca popüler kültürde ve bilim-kurgu filmlerinde bilgisayar yanıp sönen ışıkları bulunan bir kutu olarak gösterilmesinin kaynağı bu programdır.

CBS habercisi Charles Collingwood seçim gecesi stüdyoda kurulan sahte UNIVAC konsolunda. Kaynak: Computer History Museum

UNIVAC’in ilk tahmini Eisenhower’ın büyük farkla (438’e karşı 93 oy) kazanacağı yönündeydi. Bu büyük bir şaşkınlık yarattı, çünkü bir gün önce kamuoyu araştırmaları aradaki oy farkının çok küçük olacağını tahmin etmişlerdi. UNIVAC takımı bu sonucu olduğu gibi vermekten çekindi; programın parametreleriyle oynayarak elde ettikleri daha başabaş bir tahmini yayınlattılar. Ancak daha sonra elde edilen nihai sonuçlar UNIVAC’ı (daha doğrusu, onu programlayan istatistikçiyi) mükemmelen haklı çıkardı: Eisenhower 442’ye karşı 89 oyla kazandı. Daha sonra CBS spikeri UNIVAC’ın gözardı edilen ilk şaşırtıcı tahminini açıkladı. Bu olay bilgisayar tarihinde bir dönüm noktası oldu ve bilgisayarları popüler kültüre yerleştirdi.

IBM’in bilgisayar üretimine girişmesi de bu zamanlara rastlar. Çok sayıdaki uzman mühendisi ve büyük sermayesi sayesinde UNIVAC’la aralarındaki beş yıllık araştırma-geliştirme açığını bir yılda kapatabildi. 1952 Aralık ayında “Model 701” isimli bilgisayarı tantanayla piyasaya tanıttı. Model 702 ise 1953’ün Eylül ayında lanse edildi, ama ilk siparişlerin teslim edilmesi 1955’i buldu. Remington Rand o zamana kadar daha fazla UNIVAC satmış olmasına rağmen, IBM kurnaz pazarlama taktikleriyle sonraki yıllarda öne geçti: Sözgelişi, hafifletilmiş bir sistem olan Model 650’yi üniversitelere, programlama dersi açmaları şartıyla, yüzde altmış indirimle sattı. Böylece IBM ürünlerine alışık bir neslin yetişmesini sağladı, ve ilk bilgisayar bilimi bölümlerinin kurulmasını teşvik etti.

Bu şekilde mainframe bilgisayarlara talep arttı ve başka teknoloji şirketleri de sahaya çıktı. 1960’a gelindiğinde IBM %60’lık pazar payıyla en büyük üreticiydi. Onun yanı sıra Sperry Rand, Burroughs, NCR, RCA, Honeywell, GE, ve CDC şirketleri de pazarda pay sahibiydi. Bunlara topluca Pamuk Prenses ve Yedi Cüceler demek âdet olmuştu.

Mainframe bilgisayarlar büyük bir yatırımdı. Milyon dolarlara varan fiyatlarının (veya onbinlerce dolarlık kira ücretlerinin) yanı sıra, düzenli bakım ve işletim elemanlarına ihtiyaç duyuyorlardı. Yapılan masrafın boşa gitmemesi için bilgisayarların boş bırakılmaması, sürekli işletilmesi şarttı.

Sözgelişi, bir üniversitede veya araştırma kurumunda programcılar bilgisayarı kullanmak için rezervasyon yaparlar ve o süre boyunca makine tamamen onlara ait olurdu. Ancak o dönemde programlama zahmetli ve hata yapmaya çok yatkın bir işti. Rezerve edilen zamanın çoğu programcının, yazıcıdan aldığı dökümleri incelemesi ve yaptığı hataları düzeltmeye çalışmasıyla geçer, bu arada bilgisayar boşta beklerdi.

Bu usulün verimsizliğini gidermek amacıyla 1950’lerde programcı ve bilgisayarın birbirinden ayrıldığı bir düzen kuruldu. “Yığın halinde işleme” denilen bu usulde bilgisayarı işletmek için özel bir operatör görevlendirildi. Programcı, önceden hazırladığı programını (bazen bir yığın delikli kart, bazen bir basılı forma elle yazılmış olarak) bilgisayar merkezinin kabul kapısında operatöre teslim ederdi. Operatör, programları bilgisayarın kart okuyucusuna yerleştirir veya terminalde yazar, gerekiyorsa yardımcı programların (sözgelişi FORTRAN veya COBOL derleyicisi) teyplerini yükler, programı çalıştırır, ve iş bitince bilgisayarın çıktı dökümünü programcıya teslim ederdi.

Operatör manyetik teyp bantlarını mainframe bilgisayara yüklüyor. Kaynak: Jerry Mason / Science Photo Library

Bugün bilgisayarlarımızı yöneten Linux, Windows gibi “işletim sistemleri” doğrudan doğruya bu operatörün otomatikleştirilmiş halidir. Bilgisayar donanımıyla aramızda köprü kuran bu yazılım, çalıştırmak istediğimiz programı sabit diskte bulur, ana belleğe (RAM) aktarır, çalışan diğer programlarla çatışmasını engeller, klavye, fare ve ekranla etkileşim kurmasını sağlar.

Ancak, bugünün bilgisayarlarının aksine, 1960’ların ortasına kadar bilgisayarlarla “samimi” bir ilişki kurulamıyordu. Yığın işleme usulü programcının anında geri dönüş almasını engelliyordu. Bu da hem basit bir programın bile tamamlanmasının günler alması, hem de deneme-yanılma ile programlama öğrenmenin mümkün olmaması demekti.

Mesele sadece programcıların kullanım keyfi değildi; verimlilik boyutu da vardı. 1960’larda transistör ve entegre devreler sayesinde hesaplama hızı çok artmıştı. Yığın işleme ile bile bilgisayarın ana işlemcisinin boş zamanı çok fazla olabiliyordu. Operatörün programı hazırlaması, teypleri yüklemesi, hatta bilgisayarın teyplerden bilgi okuması veya yazması bile merkezi işlem birimi için çoğunlukla boşa harcanan zaman demekti.

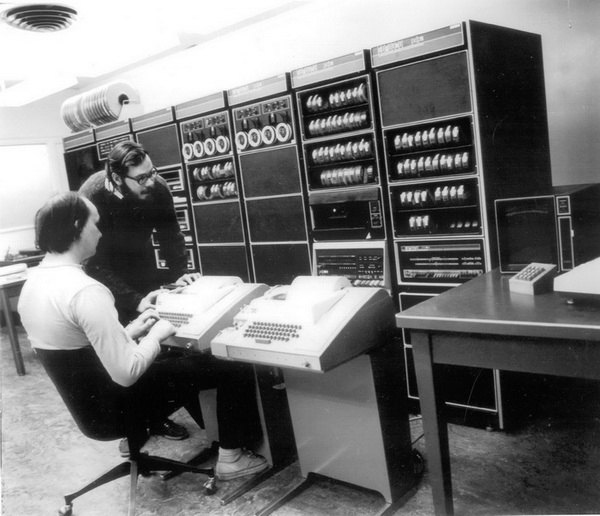

1960’ların ortalarından itibaren, mainframe bilgisayarların birden fazla kullanıcı tarafından işletilebilmesi yönünde araştırmalar başladı. “Timesharing” (paylaşımlı) tabir edilen bu sistemlerde kullanıcılar ana bilgisayarın yanında olmak zorunda değillerdi. Uzaktaki terminallerdeki klavyeler aracılığıyla programları çalıştırabiliyorlar, bilgisayar da onlara anında cevap verebiliyordu. Kullanıcılar ne yazacaklarını düşünürken, hatta yazma sırasında iki tuşa basmaları arasındaki süre içinde bile, bilgisayar birçok talimatı işleyebilecek kadar hızlıydı. Kullanıcıların her biri için sanki bilgisayar sadece kendilerine hizmet veriyormuş gibi görünse de aslında bilgisayar, her programa kısa zaman aralıkları ayırarak, bütün kullanıcıları sadakatsiz bir aşık gibi aynı anda idare edebiliyordu.

Paylaşımlı bilgisayar sistemleri programlama kültürünü demokratikleştiren ilk adımlardan biriydi. Artık bilgisayarlara “doğrudan” erişim mümkündü. Öğrenciler deneme yanılma yoluyla programlama öğrenebilecek, ve “ciddi” olmayan programlar üreterek yeni bilgiişlem imkânlarını keşfedebileceklerdi. Yayılma MIT, Stanford gibi büyük üniversitelerdeki öğrencilerden başladı.

Aynı dönemde entegre devrelerin ortaya çıkmasıyla, daha küçük ve ucuz olan, ama bilgi işleme kapasitesi yüksek paylaşımlı “minibilgisayarlar” (özellikle de DEC şirketinin ürettiği PDP serisi) piyasaya çıktı. Orta ölçekli üniversiteler bile en az bir bilgisayar satın alabilir oldular. Bunun doğrudan sonucu bilgisayar eğitiminin patlaması ve programlama bilgisinin daha çok kişiye yayılması oldu. Ünlü BASIC programlama dili bu dönemde Dartmouth üniversitesinde geliştirildi ve bilgisayar eğitiminin temel taşlarından biri haline geldi.

1964’de General Electric, Bell Laboratuvarları ve MIT ile beraber, “Multics” adını verdikleri paylaşımlı bir işletim sistemi projesine başladı. Projede işletim sistemleri ve paylaşımlı kullanıma dair birçok yenilik üretilmişti, ama zaman geçtikçe proje gitgide karmaşıklaştı ve başedilemez hale geldi. 1969’da Bell Laboratuvarları projeden ayrıldı.

Multics fazla başarılı olmayan bir ürün olarak tarihe gömüldü. Bugün daha ziyade, UNIX işletim sisteminin ilham kaynağı olarak anılır. O dönemde Multics projesine dahil olan iki Bell Laboratuvarı araştırmacısı, Ken Thompson ve Dennis Ritchie, projedeki bazı fikirleri kullanan, ama büyük ölçüde bağımsız ve daha verimli olan çok kullanıcılı bir işletim sistemi oluşturdular. Ürettikleri yazılıma, sadeliğini vurgulamak için, Multics’e nazire olarak UNIX adını verdiler. UNIX, hem nispeten basit oluşu, birçok bağımsız küçük komuttan oluşması ama komutların yanyana eklenerek karmaşık işler yapmaya imkân vermesi sayesinde çok popüler hale geldi. Bugün çok yaygın kullanılan C programlama dili de UNIX’i yazma amacıyla geliştirildi.

Ken Thompson ve Dennis Ritchie (ayakta) Bell Laboratuarında (1972). Kaynak: Computer History Museum

Bell Laboratuarının sahibi AT&T şirketi, antitröst yasaları sebebiyle bilgisayar işine giremiyordu. O yüzden UNIX isteyen herkese bedava olarak verildi. 1970’ler boyunca yaygınlaştı ve çeşitli versiyonları üretildi. 1990’larda GNU ve Linux projeleri ile kişisel bilgisayarlara aktarıldı. Bugün internetteki sunucuların büyük çoğunluğu Linux, yani UNIX kullanmaktadır.

1946-1980 arasındaki mainframe bilgisayar dönemi, bugün kullandığımız birçok teknik çözümün ortaya çıktığı, bilişim teknolojisinin çok hızlı geliştiği, daha da önemlisi programlama hevesinin birçok insana bulaştığı bir dönemdi. Bilgisayar aşırı özelleşmiş pahalı bir araçtan, her iş için kullanılan, nispeten erişilebilir bir hesaplama cihazına dönüştü. Piyasanın talebi bilgisayarların hem daha hızlı ve ucuz, hem de daha kolay kullanılabilir olmasını sağladı. Bu dönemde kazanılan momentum sayesinde gelişen ve sermaye biriktiren bilgisayar teknolojisi, bugün herkesin masasında, hatta cebinde bir bilgisayar bulundurabilmesini mümkün kıldı.

7. Manyetik veri depolama

İlk mainframe’lerden bugünkü akıllı telefonlara kadar, bütün bilgisayarlarda iki çeşit veri deposu mevcuttur: Bir programı çalıştırırken merkezi işlem biriminin doğrudan eriştiği ana bellek (RAM) ile, o anda kullanımda olmayan programların ve verilerin saklandığı ikinci depolama birimi. Genellikle ana bellek “uçucu” olarak tanımlanır, çünkü gücü kestiğiniz anda sakladığı veriler “uçar”. Bilgisayarı tekrar başlatırken ilk programların uçucu olmayan ikinci depolama aracından okunması şarttır.

Bugün bilgisayarın ana belleği olarak yarı iletken çipler kullanıyoruz. Bunlar merkezi işlem biriminin çalışmasına ayak uydurabilecek kadar hızlı ve birden fazla karmaşık programı aynı anda barındırabilecek kadar geniş. Ancak yarı iletken teknolojisi gelişmeden önce ana bellek olarak çok farklı yöntemler kullanıldı; bunlardan biri de manyetik kayıt yöntemiydi.

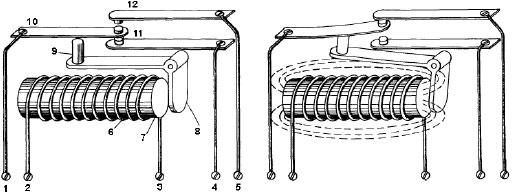

1940’ların sonunda “manyetik tambur bellekler” icat edildi. Bunlar ekseni çevresinde hızla dönen, dışı manyetik bir malzemeyle kaplı silindirlerdi ve bilgisayarların ana belleği olarak görev yapıyorlardı. Bu manyetik bellekler ucuz ve güvenilir parçalardı, ancak yavaş çalışıyor, merkezi işlem birimine yeterince hızlı cevap veremiyorlardı. Buna karşılık dönemlerine göre yüksek kapasiteye (yaklaşık 4-5 KB) sahiptiler. 1950’lerin ortasına kadar tambur bellekler kullanan çeşitli bilgisayarlar geliştirildi.

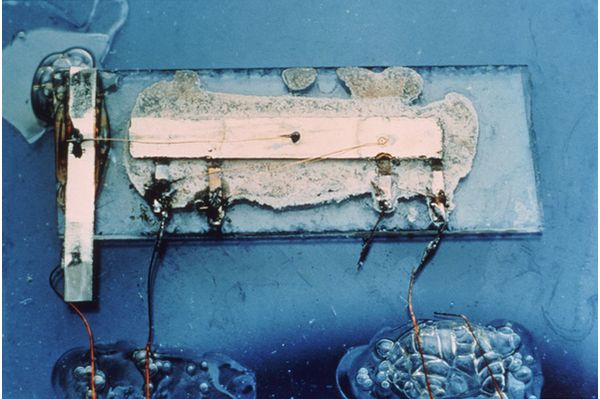

Electronic Research associates şirketi ürünü bir manyetik tambur bellek. Okuma-yazma kafaları dış kapağa bağlı. Tamburdaki çizikler ayarı bozulan kafalardan kaynaklanıyor. Kaynak: Computer History Museum

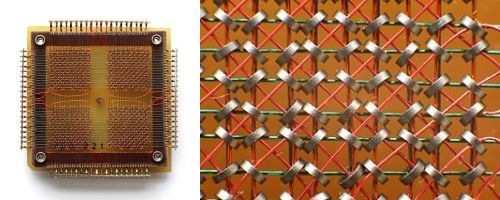

Tambur belleklerle aynı dönemde, ana bellek olarak manyetik halkalar dizisi (“çekirdek bellek”) kullanımı da yaygındı. Bunlar bir veya birkaç düzlem üzerinde döşenmiş kabloların kesişim noktalarına yerleştirilmiş demir halkalardan oluşuyordu. Her bir halka geçen akımla mıknatıslanıyor, mıknatıslanma yönüne göre 0 veya 1 değeri kodlanmış oluyordu. Yani her halka bir bilgi barındırıyordu. Bu bellekler tamburlara göre epeyce hızlılardı ve milyonlarca bite varabilen yüksek kapasiteye sahiptiler. Yüksek güvenilirlikleri sayesinde, Ay’a iniş seferinde kullanılan Apollo Yönlendirme Bilgisayarı’nda manyetik çekirdek bellekler tercih edilmişti.

256 bit barındırabilen manyetik çekirdek bellek. Sağda aynı belleğin daha yakından görünümü. Demir halkalar arasındaki mesafe yaklaşık 1mm. (Wikipedia)

Manyetik çekirdek bellekler 1970’lere kadar kullanıldı. Daha sonra yerlerini entegre devrelere bıraktılar.

Bir bilgisayarda ana belleğin yanı sıra, büyük kapasiteli bir depolama aracına da ihtiyaç vardır. Bu amaçla önce delikli kartlar kullanıldı. Programcı veya veri işleyen kişi önceden belirlenmiş bir şekilde kartlarda delikler açıyor, böylece her kart bir komut veya bir bilgi parçası barındırıyordu. Orta halli bir program için genellikle yüzlerce, belki binlerce kart gerekiyordu. IBM, bilgisayar öncesi dönemde delikli kart işleyen çeşitli otomatik makineler satmıştı ve birçok büyük işyerinin arşivi delikli kartlarla doluydu. İlk bilgisayarlar delikli kartları kullanarak hem hazır teknolojiyi kullanmış oluyorlar, hem de hazır müşteri kitlesine büyük değişiklik gerektirmeyen bir çözüm sunuyorlardı.

Fortran’la yazılmış bir program içinde Z(1) = Y + W(1) komutunu kodlayan bir delikli kart. (Wikipedia)

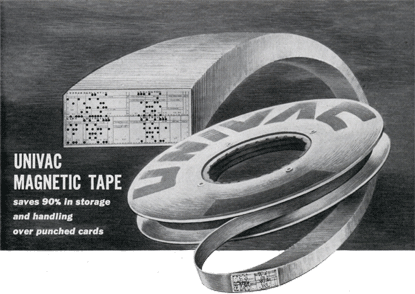

Ama delikli kartlar kullanışsızdı: Çok yer tutuyorlardı, işlenmeleri yavaştı, ve doğru sırada tutulmalarına özen göstermek gerekiyordu. Eckert ve Mauchly, 1947’deki UNIVAC tasarımında manyetik teypler kullanmaya karar vererek bir çığır açtılar. Aynı dönemde IBM de manyetik teyp üzerine araştırma yapıyordu, rakiplerinin hamlesini duyunca işi hızlandırdı, ancak 1950’lerin ortasına kadar teyp kullanan bilgisayarları piyasaya sürmedi. UNIVAC’ın ve IBM’in öncülüğünde manyetik teyp bütün mainframe bilgisayarlarda yaygın olarak kullanılmaya başladı, hatta popüler kültürde “elektronik beyin” imajının ayrılmaz parçası haline geldi.

1953 tarihli UNIVAC reklamı, manyetik teybin delikli kartlara göre %90 yer tasarrufu sağladığını vurguluyor. Kaynak:Modern Mechanix

Ne Mauchly ve Eckert, ne de IBM manyetik teypleri sıfırdan icat etmediler elbette. Manyetik malzeme kullanarak veri saklama teknolojisinin ilk adımları 1898’de, Danimarka telefon şirketinin mühendisi Valdemar Poulsen tarafından atıldı. Poulsen, uzun bir çelik tel üzerinde yanyana noktaları farklı şekilde mıknatıslayarak sesleri kodlamayı başardı. “Telegrafon” adı verilen bu icat 1900 yılındaki Paris Fuarı’nda Avusturya İmparatoru Franz Josef’in sesini kaydetmekte kullanıldı. Bu kayıt, dünyadaki en eski manyetik ses kaydıdır.

Sonraki yıllarda manyetik yöntemle ses kaydı tekniği Avrupa’da, özellikle de Almanya’da ilerletildi. 1920’lerde uzun çelik şeritler kullanılıyordu ama bunlar ağır ve bükülmez oldukları için kullanışsızdılar. 1928’de Fritz Pfleumer kağıt şeritlerini bir demir oksit tabakayla kaplayarak hafif bir teyp bandı üretti. 1930’larda AEG ilk teyp kayıt cihazını geliştirdi ve ardından IG Farben (sonradan BASF) şirketinde bugünkü hafif plastik teyp bantları icat edildi. O dönemde savaş havasına girildiği için bu icatlar gizli tutuldu. Savaştan sonra Almanya’nın işgal edilmesiyle teyp teknolojisi Amerika’ya taşındı. 1950’lerde müzik, TV, sinema sanayii tamamen manyetik teyp kullanılır olmuştu.

Bilgi depolama teknolojisinde gerçek devrim, IBM’in 1956’da geliştirdiği RAMAC’la başladı. RAMAC iki yüzü de manyetik bir malzemeyle kaplı birkaç metal diskten oluşur. Bu diskler eksenleri boyunca beraberce dönerler. Her diskin her bir yüzündeki veriler, bir pikap iğnesi gibi içeri dışarı oynayan bir “kafa” ile okunur ve yazılır. Bugün bilgisayarlarımızda bulunan sabit diskler de tamamen aynı prensiple çalışır (hızla dönmesine rağmen “sabit disk” denmesi bilgisayara bir kere takıp bırakmamızdan, taşınabilir disklerden olmamasındandır)

İlk sabit disk RAMAC’ın iç yapısı. Veriler dakikada 1200 tur hızla dönen 24 inç (61 cm) çapında elli tane diskin alt ve üst yüzeylerinde barındırılır. Kaynak: Computer History Museum

RAMAC’ın en önemli özelliği hem büyük kapasiteli (5 megabayt) olması, hem de “rastgele erişimli” olmasıydı. Yani, istenilen bir veriye hemen disk üzerinde ulaşılabiliyordu. Disklerin en yakın rakibi olan manyetik teyplerde böyle bir lüks yoktu; istenen bir veriye ulaşmak için bandı ileri veya geri sarmak gerekiyordu. Rastgele erişim sadece zaman kazandırıcı bir özellik olmanın çok ötesindeydi: Bu sayede bir bilgisayarda etkileşimli çalışmak, farklı kullanıcıların talep ettiği farklı dosyaları yüklemek, paylaşımlı bir bilgisayar sistemi yaratmak mümkün olabilmişti.

Sabit disklerin kapasitesi (birim alana sığdırılan bit sayısı), işlemcilerdeki transistörler için geçerli olan Moore yasası gibi, geçen yıllar içinde geometrik olarak arttı. Bu artış kısmen fiziken daha küçük bir alana bilgi sıkıştırma kabiliyetinden, kısmen de disklerin, depolama alanını daha verimli kullanan algoritmalar ile programlanmış olmasından kaynaklanıyor.

İnçkare başına gigabayt olarak sabit disk kapasitesinin yıllar içinde değişimi. Barry Whyte, IBM developerWorks.

Sabit diskler hâlâ büyük ölçekli veri depolama için en iyi, hatta bazen tek çözüm. Yarıiletken teknolojisine dayalı flash bellekler ve SSD’ler gibi depolama araçları hızla gelişiyor ama hem kapasiteleri hâlâ manyetik disklerin çok altında, hem de kullanıldıkça bozuluyorlar.

Manyetik depolama cihazlarının veya diğer teknolojilerin belli yıllar arasında sırayla hüküm sürdüklerini, yenisi çıkınca eskisinin bırakıldığını düşünmek hatalı olur. Yeni teknolojiler bazı konularda avantaj sağlasa da, eski teknolojiler bazen denenmişlikleri, bazen ucuzlukları, bazen de alışılmış olmaları sebebiyle uzun zaman daha yaşamaya devam ettiler. 1980’lerde üniversiteye gidenler size delikli kartlarla nasıl program yazdıklarını anlatabilirler. Manyetik teypler yakın zamana kadar büyük kapasiteleri sebebiyle kullanımda kaldılar. Teknolojik gelişim ve bir icadın bir diğerinin yerini alması uzun yıllara yayılan bir süreç olabiliyor.

Manyetik depolama, özellikle de rastgele erişimli sabit disk teknolojisi, bilgisayarlarda önceden mümkün olmayan gelişmelere yol açtı. Bilgisayarların birden fazla kullanıcı tarafından etkileşimli olarak kullanılabilmelerini sağladı. Yüksek kapasitesiyle, karmaşık programların kullanılabilmesine imkân verdi. Verilerin büyük miktarlarda biriktirilmesi ve daha sonra büyük ölçekte işlenmesi mümkün oldu.

Sabit diskler olmasaydı bilgisayarlarımızı göze hoş görünen bir pencereli grafik arayüzle kullanamaz, bir fareye tıklayarak anında bir program çalıştıramaz, fantastik bir dünyanın içine gömüldüğümüz oyunlar oynayamazdık. Gerçekçi görsel efektler kullanan filmler yapılamazdı. Veri madenciliği ve “büyük veri” kavramları düşünülemezdi. Google, Youtube, Wikipedia’yı bırakın, Web bile mevcut olmazdı.—>3.Bölüm

Kaynaklar

- AçıkBilim

- Computer History Museum

- Martin Campbell-Kelly, William Aspray. Computer: A History of the Information Machine. 2nd edition, Westview Press, 2004.

- Paul E. Ceruzzi. A History of Modern Computing. 2nd edition, MIT Press, 2003.

- Barry Whyte. A Brief History of Areal Density. 18 Eylül 2009.

BİLGİSAYAR TARİHİNDE ÇIĞIR AÇAN 10+1 İCAT (1.BÖLÜM)

Bilgi çağının keskin bir başlama çizgisi yok. 19. yüzyılda telgraf ile hızlı bir iletişim ağı oluşturulmuş, ofislerde otomatik tablolama makineleri kullanılır olmuştu. Mühendislik, astronomi ve fizikte kullanılan hesaplama cihazlarının tarihi ortaçağa, hatta antik çağa kadar uzanır. Yine de yirminci yüzyılın önemli bir farkı var: Geçtiğimiz yüzyılda malzeme teknolojisi ve fizikteki keşifler sayesinde, daha önceki özel amaçlı analog ve mekanik cihazların yerini dijital ve elektronik cihazlar aldı. Bu şekilde genel amaçlı bilgi işleme makineleri büyük ölçekli olarak imâl edilebildi, ve bugünkü bilgi toplumuna yol açılmış oldu.

Bu yazı dizisinde, dijital elektronik bilgisayarların bugünkü haline gelmesini sağlayan bazı önemli kilometre taşlarını listeleyeceğiz.

1. Röle

Röleler, 19. yüzyılın ilk yarısında, uzaklıkla zayıflayan telgraf sinyallerini güçlendirme amacıyla icat edildi. Bir rölenin içindeki elektromıknatıs, terminallerine bağlı kablodan elektrik akımı geçerse manyetik alan üretir. Bu manyetik alan, yakına yerleştirilmiş bir metal kontağı oynatır ve başka bir devrenin kapanarak akım geçirmesini sağlar. Böylece mesafeyle zayıflayan elektrik sinyalleri röle ile yeniden üretilerek ileri doğru aktarılır.

Bobinde akım yokken (solda) 1 ve 5 numaralı terminaller arasında bağlantı yoktur. Bobine akım verildiğinde (sağda) oluşan manyetik alan 8 numaralı ucu bobine doğru çeker, 9 numaralı ucun itmesiyle 10 ve 12 numaralı metaller birbirine değer ve 1 ve 5 numaralı terminaller arasında bağlantı sağlanır. (Kaynak: history-computer.com)

Röleler özünde, uzaktan kumanda edilebilen birer açma-kapama düğmesidir. Birkaç röle uygun şekilde birleştirilerek mantık işlemleri (“ve”, “veya”, “değil”, vs.) yapan elektrik devreleri inşa edilebilir. Bu mantıksal işlem devrelerini kullananarak da 0 ve 1’lerden oluşan dizileri çeşitli şekilde manipüle eden, yani bilgi işleyen yeni devreler ve ayrıca bilgiyi saklamak için bellek devreleri oluşturulabilir. Sayıların 0’lar ve 1’ler ile nasıl kodlanacağı kararlaştırıldıktan sonra, bu sayılarla aritmetik işlemler yapan, iki sayıyı birbiriyle karşılaştıran devreler de yapılabilir.

Bu prensipten hareketle 1930’larda birkaç araştırmacı, birbirlerinden habersiz olarak, röle kullanan hesaplama makineleri yapmaya giriştiler. Bu projelerden birine Bell Laboratuvarları’nda çalışan matematikçi George Stibitz öncülük ediyordu. Stibitz, 1937 yılında rölelerle hesaplama makinesi kurma fikrini geliştirmiş, hatta çok basit prototipler hazırlamıştı. Fikrini Bell yöneticilerine aktardı, ancak fikri pek hevesle karşılanmadı: Röleli bir hesaplama makinesi, o zamana kadar kullanılan mekanik hesaplayıcılara göre çok daha büyük ve hantal olacaktı. Yine de bir prototip oluşturma fırsatı yakaladı. Ortaya çıkan Karmaşık Sayı Hesaplayıcı başarılı oldu ve on yıl boyunca daha ileri modellerle gitgide geliştirildi.

George Stibitz (Kaynak: history-computer.com)

Harvard’lı fizikçi Howard Aiken, Stibitz’ten bir yıl kadar önce aynı düşünce ile yola çıkmıştı. Aiken’in projesini gerçekleştirmek için Harvard ve IBM arasında 1939’da bir anlaşma yapıldı, ama Harvard Mark Iadı verilen cihazın çalışır hale gelmesi 1944’ü buldu. O sırada askere alınmış olan Aiken, donanma tarafından Mark I’i kullanarak hesaplamalar yapmakla görevlendirildi. Grace Hopper ve Richard Bloch gibi bilgisayar tarihine geçmiş isimler, programcılık kariyerlerine o dönemde başladılar. Sonraki yıllarda Aiken donanma ve hava kuvvetleri için daha gelişkin modeller üretti. Bu süreçte Harvard, bilgisayar mühendisliğinde öncü merkezlerden biri haline geldi.

Howard Hathaway Aiken (Wikipedia)

Dehasına rağmen şartların elverişsizliğiyle önü kesilenler de vardı. Berlinli genç mühendis Konrad Zuse, röleli bilgisayar tasarımına kafa yormaya 1935’de başladı ve 1938’de ilk çalışan prototipini (Z1) tamamladı, böylece dünyadaki ilk röleli bilgisayarı geliştiren kişi olarak tarihe geçti. Zuse’nin tasarımları ABD’deki benzerlerine göre daha ileride, bugünkü prensiplere daha yakındı. Üçüncü model olan Z3 dünyanın ilk programlanabilir bilgisayarı ünvanını taşır. Aynı dönemde Zuse, ilk yüksek seviye (donanımın ayrıntılarına bağlı olmayan) programlama dili olan Plankalkül’ü geliştirdi. Sonraki model olan Z4’ün geliştirilmesi Almanya’nın savaşta yenilmesi ve Zuse’nin açlıkla mücadele ederek İsviçre’ye kaçmaya çalışması sebebiyle gecikmeye uğradı. Bu zorluklara rağmen Z4 modeli 1950’de ETH-Zürih’de işler hale getirildi. Sonraki yıllarda Zuse yeni tasarımlar üretmeye devam etti.

Konrad Zuse (Kaynak: computerhistory.org)

2. Elektron tüpleri

En sade halinde, bir elektron tüpü (triyot) basit bir araçtır: Havası boşaltılmış bir ampul içinde bir metal parçası ısıtılır, böylece bazı elektronlar metalden ayrılır. Tüpte ayrıca, ince tellerden oluşan küçük bir ızgara da bulunur. Bu ızgaraya uygulanan gerilim negatifse elektronlar katottan anoda doğru hızlanarak giderler. Gerilim pozitifse ızgara elektronları iter ve ilerlemelerini engeller.

Elektron tüpünün şematik resmi. Güç kaynağıyla ısınan filament (F) katodu (C) ısıtarak elektron salınmasına yol açar. Grid (G) elektronları anot plakasına (P) doğru hızlandırır, veya ters kuvvet uygulayarak önlerini keser. (Wikipedia)

1960’larda radyo ve TV’lerde kullanılan bir elektron tüpü. (Wikipedia)

Elektron tüpü 1906’da icat edildi, ve takip eden yıllarda radyo haberleşmesinde sinyal güçlendirici olarak yaygın şekilde kullanılmaya başlandı. Yaşı yetenler hatırlar: 1970’lere kadar radyolar kocamandı ve içlerinde “lamba” tabir edilen elektron tüpleri vardı. Tüpler de röleler gibi, uzaktan kumanda edilen açma-kapama anahtarı olarak kullanılabilirdi ve mantık devreleri içeren bilgisayarları inşa etmek için kullanılabilirlerdi.

Aiken ve Stibitz gibi 1930’ların bilgisayar öncüleri elektron tüplerinden habersiz değillerdi, ama o dönemde röleler tüplere göre daha kolay bulunuyordu, daha ucuzdu, ve oturmuş bir teknolojiye sahipti. Üstelik tüpler fazla ısınıyorlardı. Bir bilgisayarda onbinlerce tüp kullanılması gerektiğinden, bulunduğu mekânın soğutulması ciddi bir problemdi. Tüplerin arızalanmaya yatkın olması da hesabın sık sık bölünmesi riskini doğuruyordu.

Bu dezavantajlara rağmen elektronik tasarımın çekiciliği büyüktü. 1937’nin sonunda, Iowa State Üniversitesi’nde çalışan fizikçi John Atanasoff tüplerle çalışan ve ikili sayı sistemine dayalı bir elektronik hesaplama makinesi tasarladı. Parlak zekâlı bir elektrik mühendisi olan Clifford Berry’yi asistan olarak işe aldı ve 1940 yılı başında fizik binasının bodrumunda makineyi inşaya başladılar. Atanasoff-Berry Computer (ABC) olarak bilinen cihaz 1941 sonunda bitirildi. ABC’nin hesaplama kısmı mükemmel çalışıyordu, fakat delikli kartları okuyan ve yazan kısım on bin seferde bir hata yapıyordu, bu da büyük ölçekli hesaplamalarda cihazı güvenilmez kılıyordu. Bu arada ABD 2. Dünya Savaşı’na girdi, Atanasoff ve Berry ABC’nin bu eksiğini giderme fırsatı bulamadan askere alındılar. Atanasoff savaştan sonra 1948’de üniversiteyi ziyaret ettiğinde, ABC’nin kendisine haber verilmeden sökülüp atılmış olduğunu gördü.

Clifford Berry ABC’nin başında (Kaynak: Iowa State University)

Atanasoff ABC üzerinde çalışırken onu ziyaret edenlerden biri, Pennsylvania Üniversitesi’nde çalışan fizikçi John Mauchly idi. Mauchly 1942’de elektron tüpleri ile hesaplama yapmaya dair bir teklif yazmıştı, ama üniversite yönetiminin ilgisini çekememişti. Ancak, Balistik Araştırma Laboratuvarı’nın başındaki matematik doktoralı genç teğmen Herman Goldstine bu projeden haberdar oldu. Laboratuvar, top güllelerinin menzillerini veren tablolar oluşturmakla görevliydi. Yeni toplar imâl edildikçe, bu tabloların hemen hazırlanması ve savaş meydanına gönderilebilmesi gerekiyordu. Bu tablolar fırlatma açısı, hava direnci, rüzgâr yönü, vs. gibi birçok karmaşık faktör içeren zor hesaplamalar gerektiriyordu ve elle yapılan işlemler ihtiyacı karşılamayacak kadar yavaş ilerliyordu. Hızlı ve otomatik hesaplamaya ihtiyaç duyan Goldstine Mauchly’ye ihtiyaç duyduğu kaynakları vermeyi teklif etti.

Presper Eckert (solda) ve John Mauchly (history-computer.com)

Mauchly, olağanüstü yetenekli bir elektrik mühendisi olan Presper Eckert ile beraber ENIAC (Electronic Numerical Integrator And Computer) adını verdikleri bilgisayarı inşa etmeye başladı. Eckert, tüplerin ömrünü uzatmak için birçok yöntem icat etti ve güvenilir bir tasarım oluşturmayı başardı. ENIAC’ın tamamlanması 1946’yı buldu, o yüzden savaşta çok işe yaramadı, fakat sonraki bilgisayar teknolojisini oluşturan bir okul olarak tarihteki yeri çok önemlidir.

Mauchly ve Eckert, ENIAC’daki tecrübelerine dayanarak, iş dünyasının bilgi işlem ihtiyaçlarına yönelik hizmet verecek bir şirket kurdular ve ilk ticari bilgisayar olan UNIVAC’ı ürettiler. İkili, iş idaresinde çok başarılı olamadı ve 1950’de şirketlerini Remington Rand’e devrettiler. Ancak UNIVAC bilgisayarı çok popüler oldu ve “elektronik beyin” imajının popüler kültüre girmesini sağladı. UNIVAC’ın başarısı, o zamana kadar mekanik ofis ekipmanları üreten IBM’in de bilgisayar işine girmesine vesile oldu.

3. Yazılım ve donanımın ayrılması

Elektron tüpleri ile işlem yapan ENIAC gerçekten hızlıydı. O kadar hızlıydı ki, bilgisayarın çalışmasındaki darboğaz tamamen başka bir yerde ortaya çıktı: Programın hazırlanmasında.

ENIAC’ı bir matematiksel problemin çözümüne hazırlamak, yer yer yoğun fiziksel çaba gerektiren zor bir işti. Sayıların ve belleğin kağıt üzerindeki tasarımının ardından, yüzlerce anahtarın konumunun ayarlanması, yüzlerce kablonun bağlantılarının değiştirilmesi gerekiyordu. ENIAC’ı programlamak, bilgisayarın devre bağlantılarını ve iç yapısını değiştirmek demek oluyordu. Bu işlem haftalarca sürebiliyordu. Hazırlıklar bitince ENIAC gerekli tabloları yarım saatte üretiyor, ardından yeni bir problem için aynı maraton tekrar başlıyordu.

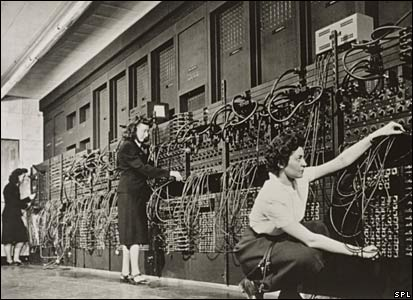

ENIAC’ın programlanmasında altı kadın teknisyen görev alıyordu.

Mauchly ve çalışma arkadaşları bu sorunun farkındaydılar ve sonraki tasarımlarda çözülmesi gerektiğini biliyorlardı. ENIAC takımını ziyaret eden ve başka bilgisayar projelerini de yakından takip eden ünlü matematikçi John von Neumann, yazdığı bir makalede “yüklenen program mimarisi” veya “von Neumann mimarisi” adı verilen bir fikir yayınladı. Bu fikre göre, bilgisayarın yapacağı işlemlerin talimatları önceden belirlenmiş ikili kodlamalarla ana bellekte saklanmalı ve bilgisayar bu talimatları sırayla işlemelidir.

Bu yaklaşım, talimatları kodlamak ve kodu çözmek için yeni devreler gerektirdiği için bilgisayar tasarımını biraz karmaşıklaştırıyor da olsa, sağladığı müthiş esneklik sayesinde hızla kabul gördü. Yüklenen program mimarisi ile kendi kendini değiştiren programlar yazılabilir, başka programları işleyen programlar oluşturulabilirdi. Genel amaçlı olacak şekilde tasarlanan bilgisayar donanımı, uygun programların yüklenmesiyle farklı işler yapmaya yönlendirilebilirdi. Yüklenen program mimarisi sayesinde Fortran, Java gibi yüksek seviye programlama dillerini, ve Linux, Windows gibi işletim sistemlerini yaratmak mümkün oldu. Programcılar bilgisayarın elektroniğine bulaşmadan yazılım geliştirebilir oldular, böylece bilgisayar kullanımı gitgide kolaylaşarak yaygınlaştı.

4. Transistör

Elektron tüplerinin rölelere göre avantajları tartışılmaz; fakat onların da kendilerine göre sorunları vardı. Her biri başparmak büyüklüğünde binlerce tüp barındıran bir bilgisayar çok büyük ebatlarda olmak zorundaydı. Bu tüplerin yaydığı ısıyı dağıtmak bir dert, bozulanları değiştirmek ayrı bir dertti. Elbette taşınabilirlik diye birşey sözkonusu değildi.

Katı hal fiziğindeki gelişmeler bu soruna çözüm bulmakta gecikmedi. Yarı iletken denen bazı malzemelere (sözgelişi, silisyum ve germanyum elementleri) uygun miktarda yabancı atomun eklenmesi ile farklı iletkenliklerde kristaller ortaya çıkarılabildiği keşfedildi. 1947 sonunda Bell Laboratuvarları’nda çalışan deneysel fizikçiler John Bardeen ve Walter Brattain, yarı iletkenleri birleştirerek bir sinyalin güçlendirilebileceğini, veya açılıp kapatılabileceğini keşfettiler. Bu icat elektron tüplerinin yerine kullanılabilirdi; üstelik çok daha az güç kullanacak, ısınma derdi olmayacak, devreler çok daha küçük ve hafif olabilecek, bozulma ve kırılma riski çok azalacaktı. Bardeen, Brattain ve laboratuar yöneticisi William Shockley, transistör adı verilen bu icatları için 1956 Nobel Fizik Ödülü’ne hak kazandılar.

Soldan sağa: Bardeen, Shockley, ve Brattain. Shockley’in icada doğrudan katkısı olmamıştı, patent başvurusunda adı da yoktu. Fakat Bell laboratuarı yönetimi kamuya dağıtılacak fotoğraflarda üçünün de bulunmasını şart koşmuştu. (Wikipedia)

Transistör üreten Mallory şirketinin 1953’de Time dergisinde yayınlanan reklamı (Flickr, kullanıcı: transistor_radios)

5. Entegre devre ve mikroişlemci

Transistörler bilgisayarların epeyce küçülmesini sağladıysa da, bu küçülmenin bir sınırı vardı. Elektronik devrelere transistörlerin tek tek elle lehimlenmesi gerekiyordu. Bu da hem üretimi yavaşlatıyordu, hem de insan elinin giremeyeceği küçük ölçeklerde çalışmayı engelliyordu.

Katı hal fiziği, özellikle de yarıiletkenler, 1950’lerden itibaren müthiş imkânlara kapı açmaya başlamıştı. 1958’de Texas Instruments’da çalışan Jack Kilby, yekpare bir yarıiletken üzerinde bir entegre devre inşa edilebileceğini düşündü. Sinüs dalgası üreten bir yarıiletken devre üretti ve fikrinin gerçekleşebileceğini gösterdi. Fairchild Semiconductors şirketinden Robert Noyce da bağımsız olarak aynı icadı geliştirdi, ama kısa bir zaman farkıyla patenti kaçırdı. Kilby ve Noyce beraberce entegre devrelerin mucidi olarak anılırlar. Kilby, öncülüğü sebebiyle 2000 Nobel Fizik Ödülü’nü aldı.

Jack Kilby’nin ürettiği ilk deneysel entegre devre (Wikipedia)

Jack Kilby’nin ürettiği ilk deneysel entegre devre (Wikipedia)

1960’larda entegre devre üretimi yaygınlaştı. ABD’de elektronik şirketlerinin toplandığı bölge Silikon Vadisi olarak benimsendi. Noyce Fairchild’dan ayrılıp Intel isimli bir şirket kurmuştu. Stanford’dan elektrik mühendisliği doktorasına sahip Intel çalışanı Ted Hoff, entegre devre fikrini iyice ileri götürdü: Bir mikroçipin üzerine tam bir bilgisayar sığdırılabileceğini savundu. Bu vizyonu takip ederek, 1971’de Intel 4004 mikroişlemcisinin geliştirilmesini sağladı. Bu öncü mikroişlemciyi birçok başka model takip etti.

Intel 4004 mikroişlemcisi (Wikipedia)

Intel 4004 mikroişlemcisi (Wikipedia)

Takip eden yıllarda üretim teknikleri gitgide geliştirildi, çok daha küçük yarıiletken yapılar imal etmek mümkün oldu ve birim alana daha da fazla sayıda transistör sığdırılabildi. Daha çok sayıda transistör bulunması, genel olarak işlemcinin yeteneklerinin daha fazla olması demektir. Böylece cep telefonlarımızda bile olağanüstü güçlü bilgisayarlar taşımamız mümkün hale geldi. Intel 4004 çipinde 2300 transistör varken, 2014 yılında piyasaya çıkacak olan Xbox One oyun konsolunun işlemcisi yaklaşık beş milyar transistör barındırıyor.

Intel’in kurucularından Gordon Moore, 1965’de yayınladığı bir makalede entegre devrelerdeki transistör sayısının her iki yılda iki katına çıktığını yazmıştı. Yani, çiplerdeki transistör sayısı zamanla üstel (veya, geometrik) olarak artmaktadır. Bugün bu gözlem Moore yasası olarak bilinir. Elbette bir doğa yasası veya teorem değil, sadece yaklaşık bir ifade, ama değişen teknolojiye rağmen elli senedir doğru kalması şaşırtıcı (veya belki de, bir numaralı mikroişlemci üreticisi olan Intel, çiplerini özellikle bu yasaya uyacak şekilde piyasaya sürüyordur (!)).

1971-2008 arasında üretilen mikroişlemcilerin transistör sayıları (noktalar) ve Moore yasası (kesik çizgi). Dikey eksenin logaritmik olması sebebiyle bu artış üsteldir. (Wikipedia)

1971-2008 arasında üretilen mikroişlemcilerin transistör sayıları (noktalar) ve Moore yasası (kesik çizgi). Dikey eksenin logaritmik olması sebebiyle bu artış üsteldir. (Wikipedia)

Gelecek ay devam edeceğiz. –>2. Bölüm

Kaynaklar

- AçıkBilim

- Michael R. Williams, A History of Computing Technology. IEEE Computer Society Press, 1997.

- History of Computers: Hardware, Software, Internet,… http://history-computer.com/index.html

- John Vincent Atanasoff and the Birth of Electronic Digital Computing. Iowa State University. http://jva.cs.iastate.edu/index.php

Yorum yazabilmek için oturum açmalısınız.